Dapatkan DISKON 93% untuk Seumur Hidup

Penawaran Eksklusif

Jangan lewatkan kesepakatan ini, dilengkapi dengan Pengelola Kata Sandi GRATIS.

Dapatkan 93% matikan FastestVPN dan manfaatkan Lulus Hulk Password Manager KONSULTASI

Dapatkan Kesepakatan Ini Sekarang!By Nick Anderson Tidak ada komentar 6 menit

Apple baru-baru ini mengumumkan dua fitur yang akan datang sebagai bagian dari pembaruan iOS di masa mendatang. Kedua fitur tersebut telah mendapat banyak kritik dari pendukung privasi. Apple tetap teguh pada keyakinannya bahwa pendekatannya tidak melanggar privasi pengguna.

Mari kita bahas apa itu Materi Pelecehan Seksual Anak (CSAM) dan bagaimana Apple menanganinya, yang menimbulkan reaksi balik dari pakar privasi di seluruh dunia.

Materi Pelecehan Seksual Anak (CSAM) adalah segala sesuatu yang mengandung materi seksual yang berhubungan dengan anak di bawah umur. Deteksi CSAM adalah teknologi yang menemukan konten tersebut dengan mencocokkannya dengan database CSAM yang dikenal.

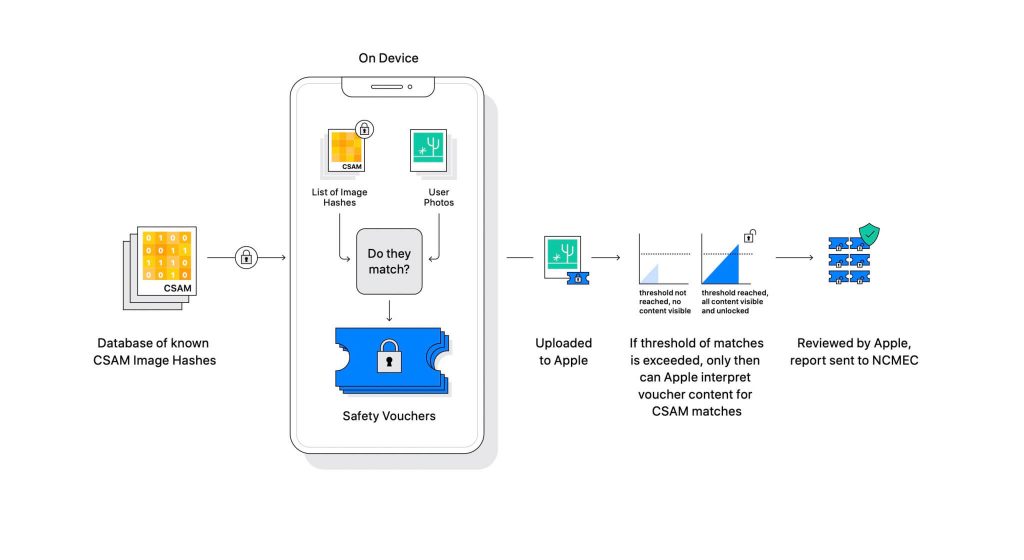

Apple mengungkapkan teknologi tersebut sebagai bagian dari pembaruan perangkat lunak yang akan datang. Ini bekerja dengan membandingkan foto yang diunggah pengguna di iCloud dengan database CSAM yang dikenal yang dikelola oleh National Center for Missing Exploited Children (NCMEC) dan organisasi keselamatan anak lainnya. Tetapi memindai gambar akan menjadi pelanggaran privasi yang besar, jadi alih-alih, teknologi Apple yang disebut NeuralHash mencocokkan hash gambar dengan hash yang disediakan oleh NCMEC.

Basis data hash CSAM yang diketahui akan disimpan di setiap perangkat. Proses pencocokan sepenuhnya bersifat kriptografi. Apple mengatakan bahwa teknologi kriptografinya membuat voucher aman saat ditemukan kecocokan dan menyimpan hasilnya. Gambar dan voucher diunggah ke iCloud jika pengguna telah mengaktifkan berbagi Foto iCloud.

Apple menciptakan mekanisme lain yang memungkinkan voucher tetap aman dari intervensi apa pun, termasuk intervensi Apple. Anggap saja sebagai kunci yang hanya terbuka setelah mencapai angka tertentu.

(Kredit gambar: Apple)

Apple tidak dapat melihat gambar yang disimpan dalam voucher kriptografi. Namun begitu ambang batas dilampaui, Apple akan melakukan intervensi manual. Bagian ini penting untuk memastikan bahwa sistem tidak menghasilkan kesalahan. Seseorang dari Apple akan memeriksa gambar secara manual dan mengonfirmasi apakah itu benar CSAM. Jika gambar diketahui sebagai CSAM, akun pengguna akan dihapus, dan lembaga penegak hukum akan diberi tahu tentang orang tersebut.

Apple menyatakan bahwa ambang yang dipilih memberikan probabilitas 1 dalam satu triliun untuk salah menandai akun.

Tidak dapat disangkal bahwa CSAM adalah masalah besar. Ketika enkripsi end-to-end dibuat untuk meningkatkan privasi, itu juga memberikan keamanan predator dari penegakan hukum. Mereka dapat membagikan materi semacam itu dan menghindari deteksi penegak hukum.

Salah satu cara untuk mencegahnya adalah dengan memindai semua gambar yang diunggah ke layanan cloud, seperti Dropbox, OneDrive, Google Drive, iCloud. Namun, Apple memimpin pendekatan yang berfokus pada privasi yang tidak melibatkan pemindaian gambar melainkan hash.

Hash adalah nilai kriptografis dari input yang telah melewati suatu algoritma. Hasilnya akan berupa nilai hash yang unik untuk masukan, seperti gambar. Jadi, alih-alih membandingkan gambar itu sendiri, nilai hashnya dapat dibandingkan untuk menentukan apakah gambar tersebut sama atau tidak.

Semua itu terdengar sempurna, bukan? Tidak tepat. Pakar privasi berpendapat bahwa tidak ada yang menghentikan Apple untuk mengganti database CSAM dengan yang lain. Basis data baru dapat mengidentifikasi aktivis HAM, pendukung kebebasan, dan apa saja yang tidak mendukung narasi pemerintah. Singkatnya, itu bisa dipersenjatai untuk pengawasan.

Sejak diumumkan, Apple mendapat kecaman dari pakar privasi di seluruh dunia. Teknologi ini digambarkan sebagai pintu belakang yang pada akhirnya akan digunakan oleh pemerintah otoriter.

Sementara Apple berkomitmen untuk tidak mengabulkan permintaan apa pun dari pemerintah, keberadaan teknologi semacam itu membuat para ahli khawatir. Organisasi privasi seperti Electronic Frontier Foundation (EFF) – termasuk mantan whistleblower CIA Edward Snowden – telah vokal tentang langkah tersebut. Dan sebanyak 90+ organisasi masyarakat sipil telah merilis sebuah Surat terbuka kepada Apple untuk meninggalkan rilis teknologi deteksi CSAM-nya. Pengumuman juga kabarnya memicu kritik di dalam Apple.

Menariknya, perusahaan yang sama pernah melawan FBI dan pengadilan federal untuk tidak membuat OS khusus dalam kasus San Bernadino 2015. Apple mengutip alasan potensi penyalahgunaan versi iOS khusus yang dapat melewati keamanan iPhone, bahkan menyebutnya "perangkat lunak yang setara dengan kanker".

Apple sangat khawatir menciptakan sesuatu yang berpotensi disalahgunakan. Namun, bertahun-tahun kemudian, Apple tampaknya bertentangan dengan pendiriannya sendiri tentang privasi. Sementara Apple terus mengatakan bahwa sebagian besar skeptisisme disebabkan oleh kebingungan seputar cara kerjanya, pakar privasi menolak penjelasan apa pun yang dikeluarkan Apple, termasuk dokumen model ancaman yang menjabarkan bagaimana sistem dirancang untuk menangani gangguan dan kesalahan.

Sistem deteksi CSAM adalah sebagian perangkat dan sebagian cloud. Sistem bekerja sepenuhnya hanya saat Anda menyalakan Foto iCloud. Mematikannya akan menonaktifkan separuh sistem lainnya, yang diperlukan agar hasil yang terdeteksi mencapai Apple.

Tidak ada cara untuk mematikan pemindaian pada perangkat. Dan Apple telah membuat sistem seperti itu

bahwa itu tidak memberi tahu pengguna jika CSAM terdeteksi di perangkat.

Ada dua bagian CSAM Apple: iCloud dan Pesan.

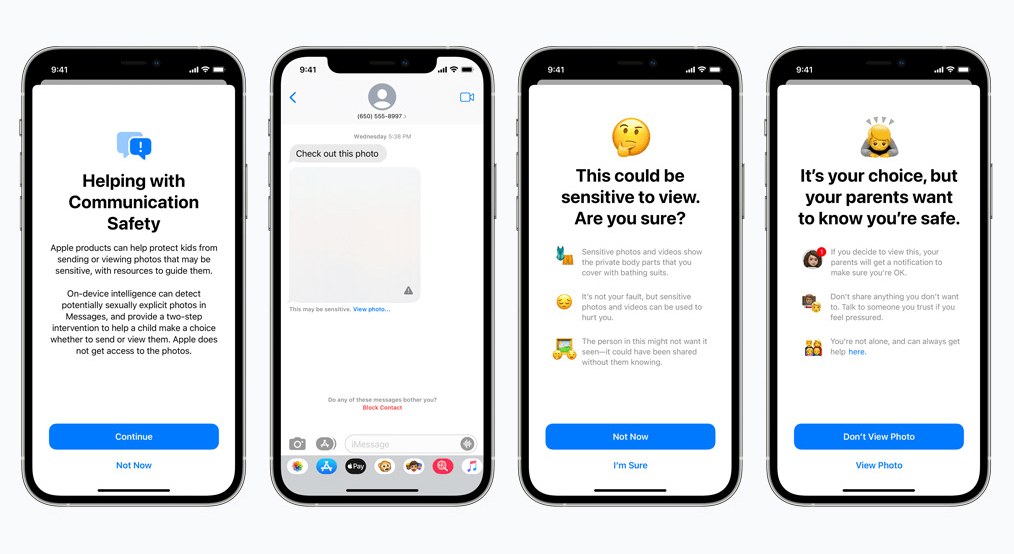

Keamanan komunikasi untuk Pesan bekerja secara berbeda dari mitra iCloud-nya. Ini menggunakan pembelajaran mesin pada perangkat untuk mengidentifikasi apakah pesan masuk atau keluar berisi foto eksplisit seksual. Orang tua akan dapat mengaktifkan fitur untuk anak-anak di akun Keluarga iCloud mereka.

Foto akan diburamkan jika bersifat eksplisit secara seksual dan ditandai sebagai sensitif. Jika pengguna tetap melihat foto itu, orang tua akan menerima pemberitahuan tentang itu. Ini juga berfungsi saat seorang anak mencoba mengirim foto yang telah ditandai eksplisit secara seksual.

Dalam perkembangan terakhir, Apple mengumumkan rencananya untuk menunda peluncuran CSAM hingga nanti.

Kami, sebagai pendukung privasi, sangat percaya bahwa jika ada alat, alat tersebut dapat dimanipulasi untuk tujuan yang tidak baik. Ada miliaran iPhone dan iPad di dunia saat ini; menerapkan teknologi yang dapat diubah secara paksa agar sesuai dengan tujuan oleh pemerintah yang menindas adalah kemungkinan yang nyata.

© Copyright 2024 VPN tercepat - Seluruh hak cipta.

Jangan lewatkan kesepakatan ini, dilengkapi dengan Pengelola Kata Sandi GRATIS.

Situs web ini menggunakan cookie sehingga kami dapat memberi Anda pengalaman pengguna sebaik mungkin. Informasi cookie disimpan di browser Anda dan melakukan fungsi seperti mengenali Anda ketika Anda kembali ke situs web kami dan membantu tim kami untuk memahami bagian mana dari situs web yang menurut Anda paling menarik dan bermanfaat.

Cookie yang Benar-benar Diperlukan harus diaktifkan setiap saat sehingga kami dapat menyimpan preferensi Anda untuk pengaturan cookie.

Jika Anda menonaktifkan cookie ini, kami tidak akan dapat menyimpan preferensi Anda. Ini berarti Anda harus mengaktifkan atau menonaktifkan cookie lagi.