Erhalten Sie 93 % RABATT auf Lebenszeit

Exklusivangebot

Lassen Sie sich dieses Angebot nicht entgehen, der Password Manager ist KOSTENLOS dabei.

Erhalten Sie 93% aus an FastestVPN und nutzen PassHulk Password Manager KOSTENLOS

Holen Sie sich dieses Angebot jetzt!By Nick Anderson Keine Kommentare 6 Мinuten

Apple hat kürzlich zwei Funktionen angekündigt, die als Teil eines zukünftigen iOS-Updates kommen werden. Die beiden Funktionen sind von Datenschützern auf viel Kritik gestoßen. Apple ist nach wie vor fest davon überzeugt, dass sein Ansatz die Privatsphäre der Nutzer nicht verletzt.

Lassen Sie uns diskutieren, was Child Sexual Abuse Material (CSAM) ist und wie Apple damit umgeht, was zu Gegenreaktionen von Datenschutzexperten weltweit führt.

Child Sexual Abuse Material (CSAM) ist alles, was sexuelles Material im Zusammenhang mit minderjährigen Kindern enthält. Die CSAM-Erkennung ist eine Technologie, die solche Inhalte findet, indem sie sie mit einer bekannten CSAM-Datenbank abgleicht.

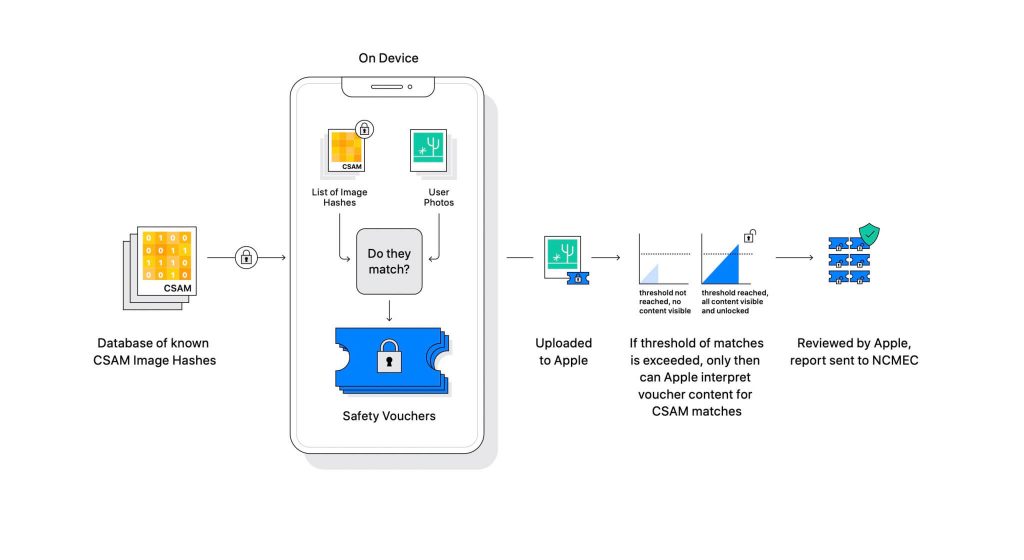

Apple enthüllte die Technologie im Rahmen eines bevorstehenden Software-Updates. Es funktioniert, indem die Fotos, die Benutzer auf iCloud hochladen, mit einer bekannten CSAM-Datenbank verglichen werden, die vom National Center for Missing Exploited Children (NCMEC) und anderen Kinderschutzorganisationen gepflegt wird. Das Scannen der Bilder wäre jedoch ein großer Verstoß gegen die Privatsphäre. Stattdessen vergleicht Apples Technologie namens NeuralHash die Hashes der Bilder mit den von NCMEC bereitgestellten Hashes.

Die Datenbank bekannter CSAM-Hashes wird auf jedem Gerät gespeichert. Der Abgleichprozess ist vollständig kryptografischer Natur. Apple sagt, dass seine Kryptographie-Technologie einen sicheren Gutschein erstellt, wenn eine Übereinstimmung gefunden wird, und das Ergebnis speichert. Das Bild und der Gutschein werden auf iCloud hochgeladen, wenn der Benutzer das Teilen von iCloud-Fotos aktiviert hat.

Apple hat einen weiteren Mechanismus entwickelt, der es dem Gutschein ermöglicht, vor Eingriffen, einschließlich Apples, sicher zu bleiben. Stellen Sie es sich als ein Schloss vor, das nur entriegelt wird, wenn eine bestimmte Zahl erreicht wird.

(Bildnachweis: Apple)

Apple kann das im kryptografischen Beleg gespeicherte Bild nicht sehen. Aber sobald die Schwelle überschritten ist, wird Apple manuell eingreifen. Dieser Teil ist wichtig, um sicherzustellen, dass das System keinen Fehler erzeugt hat. Jemand von Apple wird das Image manuell überprüfen und bestätigen, ob es sich wirklich um CSAM handelt. Wenn festgestellt wird, dass es sich bei dem Bild um CSAM handelt, wird das Konto des Benutzers gelöscht und die Strafverfolgungsbehörden werden über die Person benachrichtigt.

Apple gibt an, dass der gewählte Schwellenwert eine Wahrscheinlichkeit von 1 zu einer Billion liefert, um ein Konto falsch zu kennzeichnen.

Es lässt sich nicht leugnen, dass CSAM ein riesiges Problem ist. Als Ende-zu-Ende-Verschlüsselung geschaffen wurde, um die Privatsphäre zu stärken, bot sie auch Angreifern Schutz vor Strafverfolgungsbehörden. Sie können solches Material teilen und der Entdeckung durch die Strafverfolgungsbehörden entgehen.

Eine Möglichkeit, dies zu verhindern, besteht darin, alle Bilder zu scannen, die in Cloud-Dienste wie Dropbox, OneDrive, Google Drive, iCloud hochgeladen werden. Apple hat jedoch einen datenschutzorientierten Ansatz verfolgt, der nicht das Scannen der Bilder, sondern Hashes beinhaltet.

Ein Hash ist ein kryptografischer Wert einer Eingabe, die durch einen Algorithmus geleitet wurde. Das Ergebnis ist ein Hash-Wert, der für die Eingabe eindeutig ist, z. B. ein Bild. Anstatt also die Bilder selbst zu vergleichen, können ihre Hash-Werte verglichen werden, um festzustellen, ob es sich um dieselben Bilder handelt oder nicht.

All das klingt perfekt, oder? Nicht genau. Datenschutzexperten argumentieren, dass nichts Apple davon abhält, die Datenbank von CSAM durch eine andere zu ersetzen. Die neue Datenbank könnte Rechtsaktivisten, Unterstützer der Freiheit und alles identifizieren, was das Narrativ einer Regierung nicht unterstützt. Kurz gesagt, es könnte zur Überwachung bewaffnet werden.

Seit seiner Ankündigung steht Apple weltweit unter Beschuss von Datenschutzexperten. Die Technologie wird als Hintertür beschrieben, die autoritäre Regierungen schließlich nutzen werden.

Während Apple sich verpflichtet, auf keine Forderungen von Regierungen einzugehen, beunruhigt die bloße Existenz einer solchen Technologie die Experten. Datenschutzorganisationen wie z Electronic Frontier Foundation (EFF) – einschließlich des Ex-CIA-Whistleblowers Edward Snowden – haben sich lautstark zu diesem Schritt geäußert. Und mehr als 90 zivilgesellschaftliche Organisationen haben eine veröffentlicht offenen Brief an Apple, die Veröffentlichung seiner CSAM-Erkennungstechnologie einzustellen. Die Ankündigung hat auch Berichten zufolge löste Kritik innerhalb von Apple aus.

Interessanterweise hat dasselbe Unternehmen im Fall San Bernadino im Jahr 2015 einmal gegen das FBI und das Bundesgericht gekämpft, um ein benutzerdefiniertes Betriebssystem zu erstellen. Apple nannte Gründe für einen möglichen Missbrauch der benutzerdefinierten iOS-Version, die die Sicherheit des iPhones umgehen kann, und nannte sie sogar „Software-Äquivalent von Krebs“.

Apple war sehr besorgt, etwas zu schaffen, das das Potenzial für Missbrauch hatte. Jahre später widerspricht Apple jedoch scheinbar seiner eigenen Haltung zum Datenschutz. Während Apple weiterhin sagt, dass ein Großteil der Skepsis auf Verwirrung darüber zurückzuführen ist, wie es funktioniert, haben Datenschutzexperten jede Erklärung von Apple zurückgewiesen, einschließlich a Bedrohungsmodelldokument die festlegt, wie das System für den Umgang mit Interferenzen und Fehlern ausgelegt ist.

Das CSAM-Erkennungssystem ist teils Gerät und teils Cloud. Das System funktioniert nur dann vollständig, wenn Sie iCloud Photos aktiviert haben. Durch das Ausschalten wird die andere Hälfte des Systems deaktiviert, was erforderlich ist, damit die erkannten Ergebnisse Apple erreichen.

Es gibt keine Möglichkeit, das Scannen auf dem Gerät zu deaktivieren. Und Apple hat das System so gemacht

dass es den Benutzer nicht benachrichtigt, wenn ein CSAM auf dem Gerät erkannt wird.

Apples CSAM besteht aus zwei Teilen: iCloud und Nachrichten.

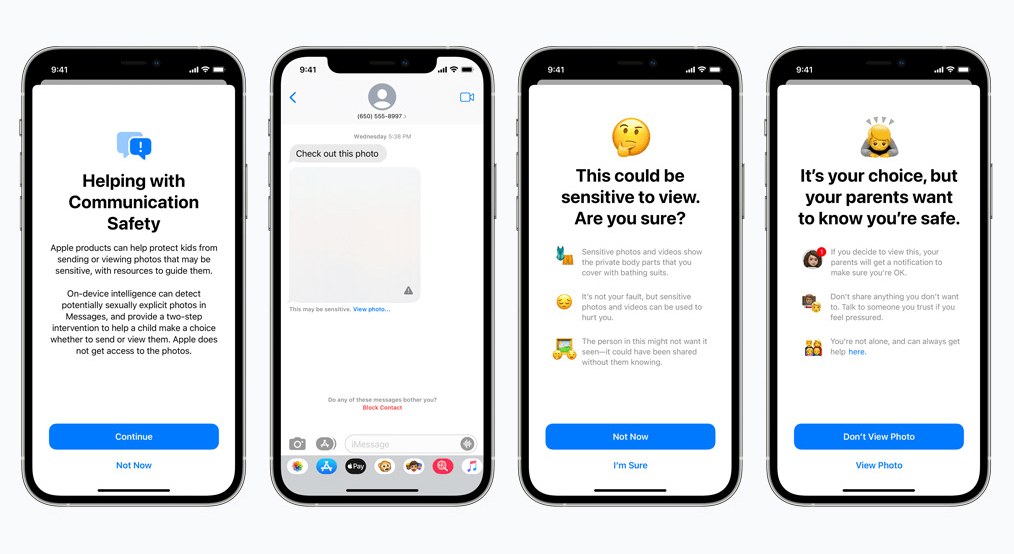

Die Kommunikationssicherheit für Nachrichten funktioniert anders als das iCloud-Pendant. Es verwendet maschinelles Lernen auf dem Gerät, um festzustellen, ob eine eingehende oder ausgehende Nachricht sexuell eindeutige Fotos enthält. Eltern können die Funktion für Kinder in ihrem iCloud-Familienkonto aktivieren.

Das Foto wird unkenntlich gemacht, wenn es sexuell eindeutig ist und als sensibel gekennzeichnet ist. Wenn der Benutzer das Foto trotzdem ansieht, erhalten die Eltern eine Benachrichtigung darüber. Dies funktioniert auch, wenn ein Kind versucht, ein Foto zu senden, das als sexuell eindeutig markiert wurde.

In einer kürzlichen Entwicklung kündigte Apple seine Pläne an, die Einführung von CSAM auf später zu verschieben.

Als Befürworter des Datenschutzes sind wir der festen Überzeugung, dass vorhandene Tools für schlechte Zwecke manipuliert werden können. Es gibt derzeit Milliarden von iPhones und iPads auf der Welt; Die Implementierung einer Technologie, die von unterdrückerischen Regierungen zwangsweise geändert werden kann, um einem Zweck zu entsprechen, ist eine reale Möglichkeit.

© Copyright 2024 Schnellstes VPN - Alle Rechte vorbehalten.

Lassen Sie sich dieses Angebot nicht entgehen, der Password Manager ist KOSTENLOS dabei.

Diese Website verwendet Cookies, um Ihnen die bestmögliche Nutzererfahrung zu bieten. Cookie-Informationen werden in Ihrem Browser gespeichert und führen Funktionen wie die Wiedererkennung auf Ihrer Website aus und helfen unserem Team dabei, zu verstehen, welche Bereiche der Website für Sie am interessantesten und nützlichsten sind.

Strictly Necessary Cookie sollte immer aktiviert sein, damit wir Ihre Einstellungen für Cookie-Einstellungen speichern können.

Wenn Sie diesen Cookie deaktivieren, können wir Ihre Einstellungen nicht speichern. Dies bedeutet, dass Sie jedes Mal, wenn Sie diese Website besuchen, Cookies erneut aktivieren oder deaktivieren müssen.