终身享受 93% 的折扣

独家交易

不要错过这笔交易,密码管理器免费提供。

积极 93% 关上 FastestVPN 并得到 绿巨人 密码管理器 免费

立即获得此优惠!By 尼克·安德森 没有评论 6分钟

Apple 最近宣布了两项功能,这些功能将作为未来 iOS 更新的一部分出现。 这两项功能遭到了隐私权倡导者的大量批评。 Apple 仍然坚信其做法不会侵犯用户的隐私。

让我们讨论什么是儿童性虐待材料 (CSAM) 以及 Apple 如何解决它,它引起了全球隐私专家的强烈反对。

儿童性虐待材料 (CSAM) 是指任何包含与未成年儿童相关的性材料的内容。 CSAM 检测是一种通过将此类内容与已知的 CSAM 数据库进行匹配来找到此类内容的技术。

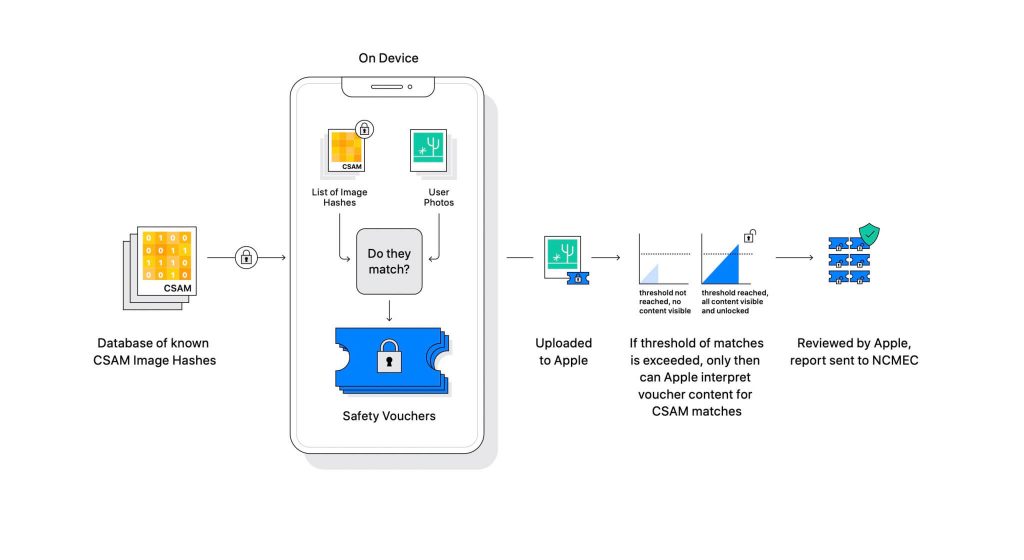

Apple 在即将推出的软件更新中透露了这项技术。 它的工作原理是将用户上传到 iCloud 的照片与国家失踪受虐儿童中心 (NCMEC) 和其他儿童安全组织维护的已知 CSAM 数据库进行比较。 但扫描图片会严重侵犯隐私,因此,Apple 的名为 NeuralHash 的技术会将图像的哈希值与 NCMEC 提供的哈希值进行匹配。

已知 CSAM 哈希的数据库将存储在每个设备上。 匹配过程本质上是完全加密的。 Apple 表示,当找到匹配项并存储结果时,其加密技术会创建一个安全凭证。 如果用户启用了 iCloud 照片共享,图像和优惠券将上传到 iCloud。

苹果公司创建了另一种机制,使代金券能够保持安全,免受任何干预,包括苹果的干预。 把它想象成一把锁,只有达到一定的数字才会解锁。

(图片来源:Apple)

Apple 看不到存储在加密凭证中的图像。 但一旦超过门槛,苹果就会采取人工干预。 这部分对于确保系统没有产生错误很重要。 Apple 的专人会手动检查图像并确认它是否真的是 CSAM。 如果发现图像是 CSAM,用户的帐户将被删除,并将通知执法机构有关此人的信息。

Apple 表示,所选阈值为错误标记帐户提供了万亿分之一的概率。

不可否认,CSAM 是一个巨大的问题。 当创建端到端加密以加强隐私时,它还为执法者提供了掠夺者的安全。 他们可以分享此类材料并逃避执法部门的侦查。

防止它的一种方法是扫描所有上传到云服务的图像,例如 Dropbox、OneDrive、Google Drive、iCloud。 然而,Apple 领导了一种以隐私为中心的方法,该方法不涉及扫描图像,而是散列。

哈希是已通过算法传递的输入的加密值。 结果将是输入的唯一哈希值,例如图像。 因此,不是比较图像本身,而是可以比较它们的哈希值来确定它们是否是相同的图像。

所有这些听起来很完美,对吧? 不完全是。 隐私专家争辩说,没有什么可以阻止 Apple 用另一个数据库替换 CSAM 的数据库。 新数据库可以识别维权人士、自由支持者以及任何不支持政府叙述的人。 简而言之,它可以被武器化用于监视。

自宣布以来,Apple 一直受到全球隐私专家的抨击。 该技术被描述为专制政府最终会使用的后门。

尽管苹果公司承诺不会屈服于政府的任何要求,但这种技术的存在本身就让专家们感到担忧。 隐私组织,例如 电子前沿基金会 (EFF)——包括前中央情报局举报人爱德华·斯诺登——一直对这一举动直言不讳。 多达 90 多个民间社会组织发布了一份 公开信 要求苹果公司放弃发布其 CSAM 检测技术。 该公告还 据说 引发了苹果内部的批评。

有趣的是,同一家公司曾在 2015 年圣贝纳迪诺案中与 FBI 和联邦法院抗争,反对创建自定义操作系统。 Apple 列举了可能滥用可以绕过 iPhone 安全性的自定义 iOS 版本的原因,甚至称其为“相当于癌症的软件”。

Apple 非常担心创造出可能被滥用的东西。 然而,多年以后,Apple 似乎在与自己在隐私问题上的立场相矛盾。 尽管苹果公司继续表示,大部分怀疑是由于对其运作方式的混淆,但隐私专家驳回了苹果公司发布的任何解释,包括 威胁模型文档 这说明了系统是如何设计来处理干扰和错误的。

CSAM 检测系统是部分设备和部分云。 只有当您打开 iCloud 照片时,系统才能完全运行。 关闭它会禁用系统的另一半,这是检测结果到达 Apple 所必需的。

无法关闭设备上的扫描。 Apple 已经让这个系统变得如此

如果在设备上检测到 CSAM,它不会通知用户。

Apple 的 CSAM 有两个部分:iCloud 和 Messages。

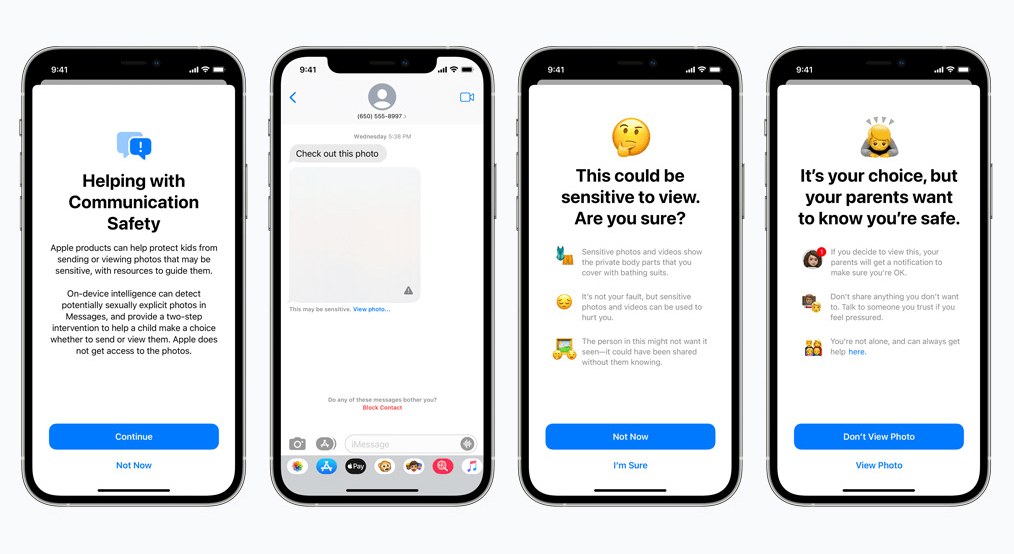

Messages 的通信安全性与其 iCloud 对应物的工作方式不同。 它使用设备上的机器学习来识别传入或传出的消息是否包含色情照片。 父母将能够在他们的 iCloud 家庭帐户上为孩子启用该功能。

如果照片本质上是露骨的并且被标记为敏感,则照片将变得模糊。 如果用户继续查看照片,家长将收到相关通知。 当孩子试图发送一张被标记为色情的照片时,这也适用。

在最近的发展中,Apple 宣布计划将 CSAM 的推出推迟到以后。

作为隐私倡导者,我们坚信,如果工具存在,它们可能会被用于恶意目的。 现在世界上有数十亿部 iPhone 和 iPad; 实施一项可以被专制政府强制改变以适应目的的技术是一种真正的可能性。

不要错过这笔交易,密码管理器免费提供。

本网站使用cookies,以便我们能够为您提供尽可能最佳的用户体验。 Cookies存储在您的浏览器中,执行的功能包括在您返回我们的网站时识别您的身份,并帮助我们的团队了解您觉得哪些网站最有趣和最有用的部分。

应始终启用严格必要的Cookie,以便我们可以保存您的Cookie偏好。

如果您停用此Cookie,我们将无法保存您的偏好设置。 这意味着您将需要再次启用或禁用Cookie。