ライフタイムで 93% オフ

独占取引

この取引をお見逃しなく。Password Manager が無料で付属しています。

入手 視聴者の38%が オンオフ FastestVPN とアベイルズ パスハルク パスワードマネージャ 無料

今すぐこの取引を入手してください!By ニック・アンダーソン コメントはありません 6 minutes

Apple は最近、将来の iOS アップデートの一部として提供される XNUMX つの機能を発表しました。 この XNUMX つの機能は、プライバシー擁護者から多くの批判を受けています。 Apple は、そのアプローチがユーザーのプライバシーを侵害しないという確固たる信念を維持しています。

Child Sexual Abuse Material (CSAM) とは何か、そして世界中のプライバシー専門家からの反発を引き起こしている Apple の取り組みについてお話しましょう。

Child Sexual Abuse Material (CSAM) とは、未成年の子供に関連する性的な内容を含むあらゆるものです。 CSAM 検出は、既知の CSAM データベースと照合することにより、そのようなコンテンツを見つける技術です。

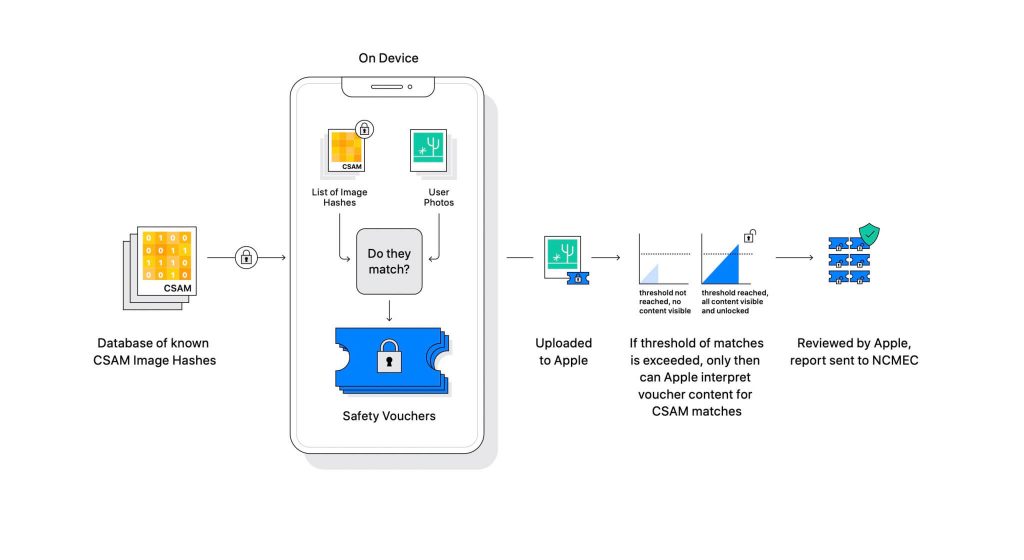

Apple は、今後のソフトウェア アップデートの一部としてこの技術を明らかにしました。 これは、ユーザーが iCloud にアップロードした写真を、National Center for Missing Exploited Children (NCMEC) およびその他の児童安全組織によって維持されている既知の CSAM データベースと比較することによって機能します。 しかし、写真をスキャンすることはプライバシーの重大な侵害になるため、代わりに、NeuralHash と呼ばれる Apple の技術が画像のハッシュと NCMEC が提供するハッシュを照合します。

既知の CSAM ハッシュのデータベースは、すべてのデバイスに保存されます。 照合プロセスは、本質的に完全に暗号化されています。 Apple によると、一致が見つかった場合、その暗号化技術が安全なバウチャーを作成し、結果を保存します。 ユーザーが iCloud 写真の共有を有効にしている場合、画像とバウチャーは iCloud にアップロードされます。

Apple は、Apple を含むあらゆる介入に対してバウチャーを安全に保つことができる別のメカニズムを作成しました。 特定の数値に達した場合にのみロックが解除されるロックと考えてください。

(画像クレジット:アップル)

Apple は、暗号バウチャーに保存されている画像を見ることができません。 ただし、しきい値を超えると、Apple は手動で介入します。 この部分は、システムがエラーを生成していないことを確認するために重要です。 Apple の担当者が手動でイメージをチェックし、それが本当に CSAM であるかどうかを確認します。 画像が CSAM であることが判明した場合、ユーザーのアカウントは削除され、法執行機関にその人物について通知されます。

Apple は、選択されたしきい値により、アカウントに誤ってフラグが立てられる可能性が 1 兆分の XNUMX になると述べています。

CSAM が大きな問題であることは否定できません。 プライバシーを強化するためにエンドツーエンドの暗号化が作成されたとき、法執行機関からの捕食者の安全も提供されました. 彼らはそのような資料を共有し、法執行機関の検出を回避できます。

これを防ぐ方法の XNUMX つは、Dropbox、OneDrive、Google Drive、iCloud などのクラウド サービスにアップロードされているすべての画像をスキャンすることです。 ただし、Apple は、画像のスキャンではなくハッシュを使用する、プライバシーに重点を置いたアプローチを主導しました。

ハッシュは、アルゴリズムを通過した入力の暗号化された値です。 結果は、画像などの入力に固有のハッシュ値になります。 したがって、画像自体を比較する代わりに、それらのハッシュ値を比較して、それらが同じ画像であるかどうかを判断できます。

それはすべて完璧に聞こえますよね? ではない正確に。 プライバシーの専門家は、Apple が CSAM のデータベースを別のデータベースに置き換えることを止めるものは何もないと主張しています。 新しいデータベースは、権利活動家、自由の支持者、および政府の主張を支持しないあらゆるものを特定できる可能性があります。 要するに、監視のために兵器化される可能性があります。

発表以来、Apple は世界中のプライバシー専門家から非難されてきました。 このテクノロジーは、権威主義的な政府が最終的に使用するようになるバックドアとして説明されています。

Apple は政府からのいかなる要求にも屈しないと約束しているが、そのような技術の存在自体が専門家を不安にさせている. などのプライバシー団体 電子フロンティア財団 (EFF) – 元 CIA の内部告発者であるエドワード・スノーデンを含む – は、この動きについて声を上げてきました。 そして、90 以上もの市民社会組織が、 公開書簡 CSAM 検出技術のリリースを放棄するよう Apple に要求します。 発表にはまた 報道によると アップル社内で批判を呼んだ。

興味深いことに、同じ会社は、2015 年の San Bernadino 事件で、カスタム OS の作成に対して FBI および連邦裁判所と争ったことがあります。 Apple は、iPhone のセキュリティを回避できるカスタム iOS バージョンの潜在的な悪用の理由を挙げ、それを「癌に相当するソフトウェア」とさえ呼んでいます。

Apple は、誤用される可能性のあるものを作成することを非常に懸念していました。 しかし、数年後、Apple はプライバシーに対する独自のスタンスに矛盾しているように見えます。 Apple は懐疑論の多くはその仕組みをめぐる混乱によるものだと言い続けているが、プライバシーの専門家は Apple が出した説明をすべて却下している。 脅威モデル ドキュメント これは、干渉とエラーを処理するためにシステムがどのように設計されているかを示しています。

CSAM 検出システムは、一部はデバイスであり、一部はクラウドです。 システムは、iCloud 写真がオンになっている場合にのみ完全に機能します。 オフにすると、システムの残りの半分が無効になります。これは、検出結果が Apple に到達するために必要です。

オンデバイス スキャンをオフにする方法はありません。 そしてAppleはシステムをそのようなものにしました

デバイスで CSAM が検出された場合、ユーザーに通知しないこと。

Apple の CSAM には、iCloud とメッセージという XNUMX つの部分があります。

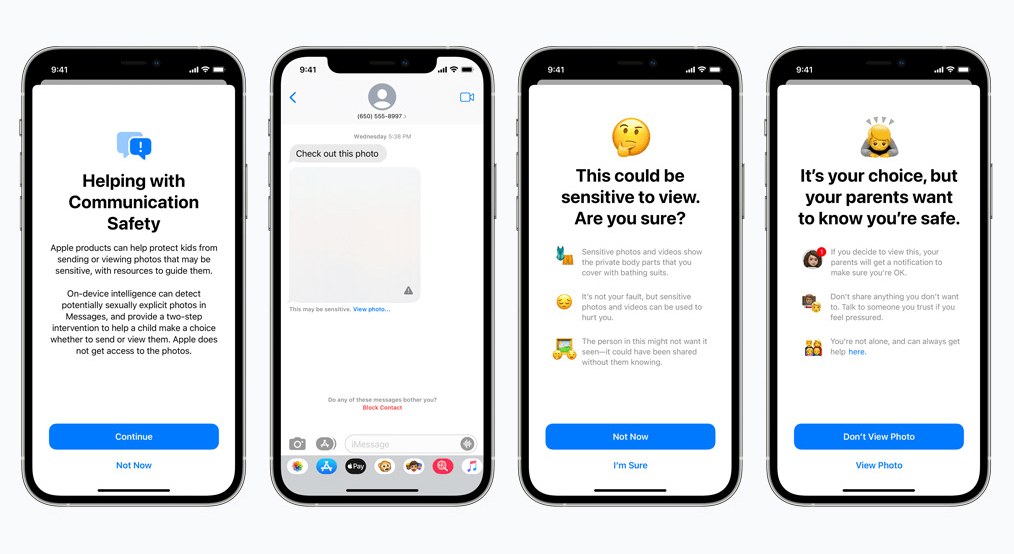

メッセージの通信の安全性は、対応する iCloud とは異なる方法で機能します。 オンデバイスの機械学習を使用して、送受信メッセージに性的に露骨な写真が含まれているかどうかを識別します。 保護者は、iCloud ファミリー アカウントで子供向けの機能を有効にすることができます。

性的描写が露骨で、センシティブとマークされている場合、写真はぼやけます。 それでもユーザーが写真を表示すると、保護者はその写真に関する通知を受け取ります。 これは、子供が性的に露骨なマークが付けられた写真を送信しようとしている場合にも機能します。

最近の開発では、Apple は CSAM のロールアウトを後で延期する計画を発表しました。

プライバシーの擁護者として、私たちはツールが存在する場合、悪意のある目的で操作される可能性があると強く信じています. 現在、世界中には何十億もの iPhone と iPad があります。 抑圧的な政府が目的に合わせて強制的に変更できる技術を実装することは現実的な可能性です。

© Copyright 2024 最速のVPN - すべての権利予約。

この取引をお見逃しなく。Password Manager が無料で付属しています。

このウェブサイトはクッキーを使用しており、可能な限り最高のユーザーエクスペリエンスを提供しています。 クッキー情報はブラウザに保存され、ウェブサイトに戻ったときにあなたを認識し、最も興味深く有用なウェブサイトのセクションをチームが理解できるようにするなどの機能を果たします。

厳密に必要なCookieを有効にして、Cookieの設定を保存できるようにする必要があります。

このCookieを無効にすると、お客様の設定を保存することはできません。 これは、あなたがこのウェブサイトを訪れるたびに、再度クッキーを有効または無効にする必要があることを意味します。