Ottieni il 93% di sconto a vita

Affare esclusivo

Non perdere questa offerta, include Password Manager GRATUITO.

Ottieni 93% spento acceso FastestVPN e disp Passa Hulk Password manager GRATIS

Ottieni subito questo affare!By Nick Anderson Non ci sono commenti 6 minuti

Apple ha recentemente annunciato due funzionalità che arriveranno come parte di un futuro aggiornamento iOS. Le due funzionalità sono state accolte con molte critiche dai sostenitori della privacy. Apple rimane ferma nella convinzione che il suo approccio non violi la privacy degli utenti.

Parliamo di cos'è il materiale pedopornografico (CSAM) e di come Apple lo sta affrontando, provocando il contraccolpo degli esperti di privacy di tutto il mondo.

Il materiale pedopornografico (CSAM) è tutto ciò che contiene materiale sessuale relativo a minori. Il rilevamento CSAM è una tecnologia che trova tali contenuti confrontandoli con un database CSAM noto.

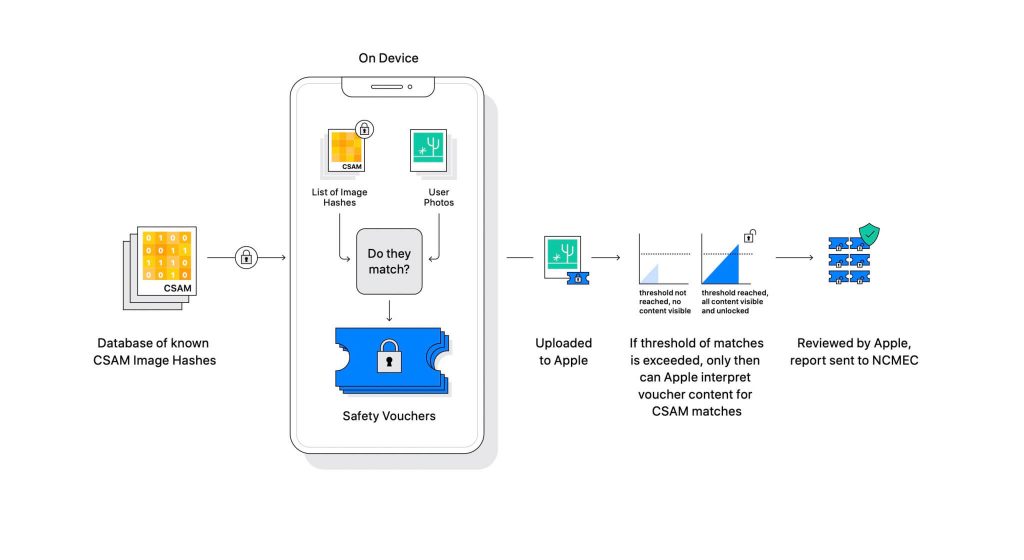

Apple ha rivelato la tecnologia come parte di un prossimo aggiornamento software. Funziona confrontando le foto che gli utenti caricano su iCloud con un noto database CSAM gestito dal National Center for Missing Exploited Children (NCMEC) e altre organizzazioni per la sicurezza dei bambini. Ma scansionare le immagini sarebbe un'enorme violazione della privacy, quindi, invece, la tecnologia di Apple chiamata NeuralHash confronta gli hash delle immagini con gli hash forniti da NCMEC.

Il database degli hash CSAM noti verrà archiviato su ogni dispositivo. Il processo di corrispondenza è di natura completamente crittografica. Apple afferma che la sua tecnologia di crittografia crea un buono sicuro quando viene trovata una corrispondenza e memorizza il risultato. L'immagine e il voucher vengono caricati su iCloud se l'utente ha abilitato la condivisione delle foto di iCloud.

Apple ha creato un altro meccanismo che consente al voucher di rimanere al sicuro da qualsiasi intervento, incluso quello di Apple. Pensalo come un lucchetto che si sblocca solo quando raggiunge un certo numero.

(Crediti immagine: Apple)

Apple non può vedere l'immagine memorizzata nel voucher crittografico. Ma una volta superata la soglia, Apple intraprenderà un intervento manuale. Questa parte è importante per garantire che il sistema non abbia prodotto un errore. Qualcuno di Apple controllerà manualmente l'immagine e confermerà se si tratta davvero di CSAM. Se l'immagine risulta essere di materiale pedopornografico, l'account dell'utente verrà eliminato e le forze dell'ordine riceveranno una notifica in merito alla persona.

Apple afferma che la soglia selezionata offre una probabilità di 1 su un trilione di contrassegno errato di un account.

Non si può negare che il CSAM sia un grosso problema. Quando è stata creata la crittografia end-to-end per rafforzare la privacy, ha anche fornito sicurezza ai predatori dalle forze dell'ordine. Possono condividere tale materiale ed eludere il rilevamento delle forze dell'ordine.

Un modo per impedirlo è scansionare tutte le immagini caricate su servizi cloud, come Dropbox, OneDrive, Google Drive, iCloud. Tuttavia, Apple ha adottato un approccio incentrato sulla privacy che non prevede la scansione delle immagini ma piuttosto gli hash.

Un hash è un valore crittografico di un input che è stato passato attraverso un algoritmo. Il risultato sarà un valore hash univoco per l'input, ad esempio un'immagine. Quindi, invece di confrontare le immagini stesse, i loro valori hash possono essere confrontati per determinare se sono le stesse immagini o meno.

Tutto ciò sembra perfetto, vero? Non esattamente. Gli esperti di privacy sostengono che nulla impedisce ad Apple di sostituire il database di CSAM con un altro. Il nuovo database potrebbe identificare attivisti per i diritti, sostenitori della libertà e tutto ciò che non supporta la narrativa di un governo. In breve, potrebbe essere utilizzato come arma per la sorveglianza.

Dal suo annuncio, Apple è stata presa di mira dagli esperti di privacy di tutto il mondo. La tecnologia viene descritta come una backdoor che i governi autoritari finiranno per utilizzare.

Sebbene Apple si impegni a non concedere alcuna richiesta da parte dei governi, l'esistenza stessa di tale tecnologia ha preoccupato gli esperti. Organizzazioni per la privacy come Electronic Frontier Foundation (EFF) - incluso l'ex informatore della CIA Edward Snowden - hanno parlato apertamente della mossa. E oltre 90 organizzazioni della società civile hanno rilasciato un lettera aperta ad Apple per abbandonare il rilascio della sua tecnologia di rilevamento CSAM. L'annuncio ha anche riferito ha suscitato critiche all'interno di Apple.

È interessante notare che la stessa azienda una volta ha combattuto l'FBI e il tribunale federale contro la creazione di un sistema operativo personalizzato nel caso San Bernardino del 2015. Apple ha citato motivi di potenziale uso improprio della versione iOS personalizzata che può aggirare la sicurezza di iPhone, definendolo addirittura "equivalente software del cancro".

Apple era molto preoccupata di creare qualcosa che avesse il potenziale per un uso improprio. Tuttavia, anni dopo, Apple sta apparentemente contraddicendo la propria posizione sulla privacy. Mentre Apple continua a dire che gran parte dello scetticismo è dovuto alla confusione che circonda il suo funzionamento, gli esperti di privacy hanno respinto qualsiasi spiegazione fornita da Apple, inclusa una documento del modello di minaccia che illustra come il sistema è progettato per gestire interferenze ed errori.

Il sistema di rilevamento CSAM è in parte dispositivo e in parte cloud. Il sistema funziona completamente solo quando hai attivato iCloud Photos. La disattivazione disabiliterà l'altra metà del sistema, necessaria affinché i risultati rilevati raggiungano Apple.

Non è possibile disattivare la scansione sul dispositivo. E Apple ha reso il sistema tale

che non notifica all'utente se viene rilevato un CSAM sul dispositivo.

Ci sono due parti nel CSAM di Apple: iCloud e Messaggi.

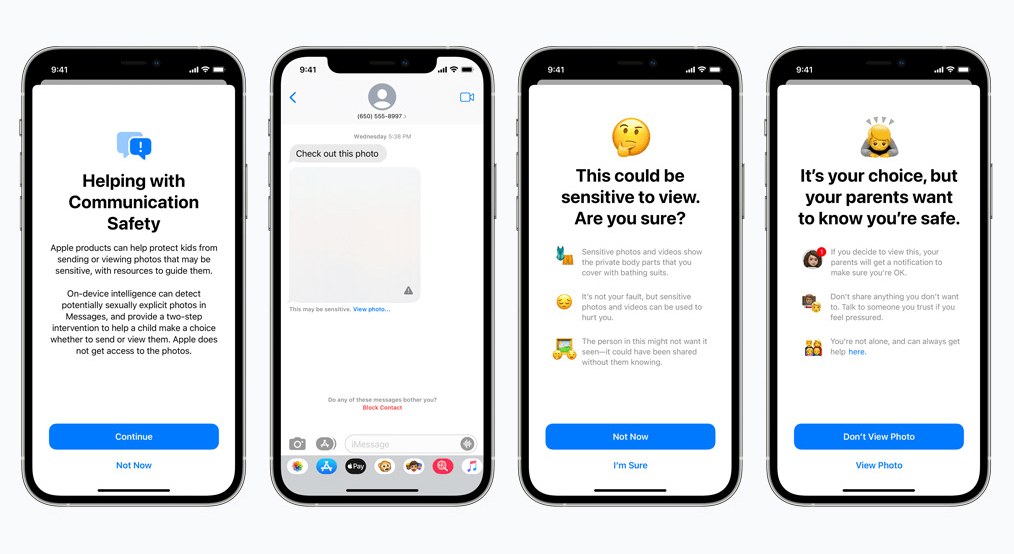

La sicurezza delle comunicazioni per Messaggi funziona in modo diverso rispetto alla sua controparte iCloud. Utilizza l'apprendimento automatico sul dispositivo per identificare se un messaggio in entrata o in uscita contiene foto sessualmente esplicite. I genitori potranno abilitare la funzione per i bambini sul proprio account iCloud Family.

La foto sarà sfocata se è di natura sessualmente esplicita e contrassegnata come sensibile. Se l'utente procede comunque alla visualizzazione della foto, il genitore riceverà una notifica in merito. Funziona anche quando un bambino cerca di inviare una foto contrassegnata come sessualmente esplicita.

In uno sviluppo recente, Apple ha annunciato i suoi piani per ritardare il lancio di CSAM fino a più tardi.

Noi, in qualità di sostenitori della privacy, crediamo fermamente che se esistono strumenti, possono essere manipolati per scopi illeciti. Ci sono miliardi di iPhone e iPad nel mondo in questo momento; l'implementazione di una tecnologia che può essere modificata coercitivamente per adattarsi a uno scopo da parte di governi oppressivi è una possibilità reale.

© Copyright 2024 VPN più veloce - Tutti i diritti riservati.

Non perdere questa offerta, include Password Manager GRATUITO.

Questo sito Web utilizza i cookie per consentirci di offrire la migliore esperienza utente possibile. Le informazioni sui cookie sono memorizzate nel tuo browser ed eseguono funzioni come riconoscerti quando ritorni sul nostro sito web e aiutando il nostro team a capire quali sezioni del sito web trovi più interessanti e utili.

Cookie strettamente necessari devono essere abilitati in ogni momento in modo che possiamo salvare le tue preferenze per le impostazioni dei cookie.

Se disabiliti questo cookie, non saremo in grado di salvare le tue preferenze. Ciò significa che ogni volta che visiti questo sito web dovrai abilitare o disabilitare nuovamente i cookie.