Obtenez 93 % de réduction sur la durée de vie

Offre exclusive

Ne manquez pas cette offre, elle est livrée avec Password Manager GRATUITEMENT.

Obtenez 93% éteint allumé FastestVPN et profiter PassHulk Password Manager Sauvegardes

Obtenez cette offre maintenant !By Nick Anderson Commentaires 6 minutes

Apple a récemment annoncé deux fonctionnalités qui feront partie d'une future mise à jour iOS. Les deux fonctionnalités ont suscité de nombreuses critiques de la part des défenseurs de la vie privée. Apple reste ferme dans sa conviction que sa démarche ne viole pas la vie privée des utilisateurs.

Discutons de ce qu'est le matériel d'abus sexuel d'enfants (CSAM) et de la manière dont Apple s'y attaque, ce qui provoque des réactions négatives de la part des experts de la protection de la vie privée du monde entier.

Le matériel d'abus sexuel d'enfants (CSAM) est tout ce qui contient du matériel sexuel lié à des enfants mineurs. La détection CSAM est une technologie qui trouve ce contenu en le comparant à une base de données CSAM connue.

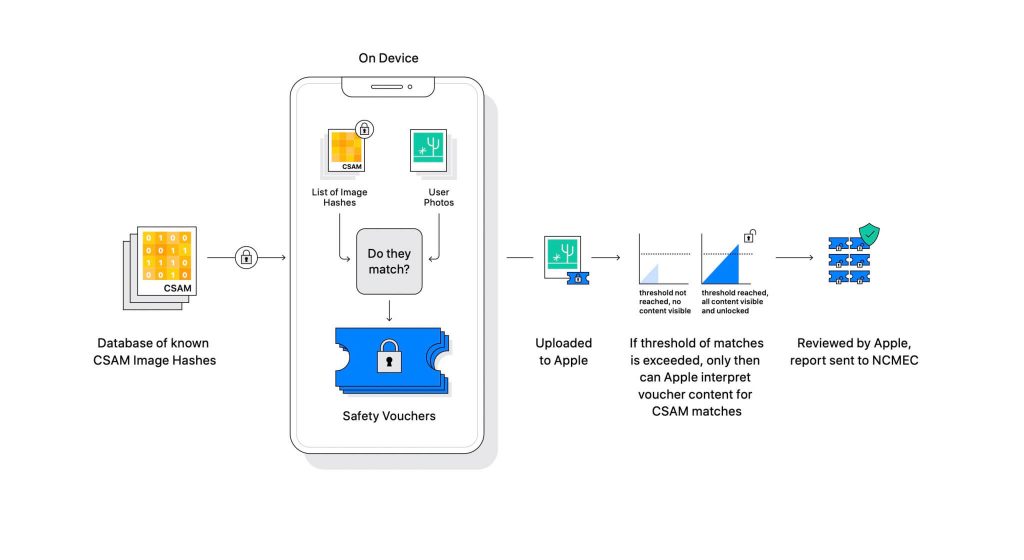

Apple a révélé la technologie dans le cadre d'une prochaine mise à jour logicielle. Cela fonctionne en comparant les photos que les utilisateurs téléchargent sur iCloud avec une base de données CSAM connue gérée par le National Center for Missing Exploited Children (NCMEC) et d'autres organisations de sécurité des enfants. Mais la numérisation des images constituerait une énorme violation de la vie privée, donc à la place, la technologie d'Apple appelée NeuralHash fait correspondre les hachages des images aux hachages fournis par NCMEC.

La base de données des hachages CSAM connus sera stockée sur chaque appareil. Le processus d'appariement est de nature entièrement cryptographique. Apple affirme que sa technologie de cryptographie crée un bon sécurisé lorsqu'une correspondance est trouvée et stocke le résultat. L'image et le bon sont téléchargés sur iCloud si l'utilisateur a activé le partage de photos iCloud.

Apple a créé un autre mécanisme qui permet au bon de rester sécurisé contre toute intervention, y compris celle d'Apple. Considérez-le comme un verrou qui ne se déverrouille qu'une fois qu'il atteint un certain nombre.

(Crédits image : Apple)

Apple ne peut pas voir l'image stockée dans le bon cryptographique. Mais une fois le seuil franchi, Apple procédera à une intervention manuelle. Cette partie est importante pour s'assurer que le système n'a pas produit d'erreur. Quelqu'un d'Apple vérifiera manuellement l'image et confirmera s'il s'agit vraiment de CSAM. S'il s'avère que l'image est du CSAM, le compte de l'utilisateur sera supprimé et les forces de l'ordre seront informées de la personne.

Apple déclare que le seuil sélectionné offre une probabilité de 1 sur XNUMX milliards de signaler incorrectement un compte.

Il est indéniable que le CSAM est un énorme problème. Lorsque le chiffrement de bout en bout a été créé pour renforcer la confidentialité, il a également fourni aux prédateurs une protection contre les forces de l'ordre. Ils peuvent partager ce matériel et échapper à la détection des forces de l'ordre.

Une façon de l'empêcher consiste à analyser toutes les images téléchargées sur des services cloud, tels que Dropbox, OneDrive, Google Drive, iCloud. Cependant, Apple a mené une approche axée sur la confidentialité qui n'implique pas la numérisation des images, mais plutôt des hachages.

Un hachage est une valeur cryptographique d'une entrée qui a été transmise à un algorithme. Le résultat sera une valeur de hachage unique à l'entrée, telle qu'une image. Ainsi, au lieu de comparer les images elles-mêmes, leurs valeurs de hachage peuvent être comparées pour déterminer s'il s'agit ou non des mêmes images.

Tout cela semble parfait, non ? Pas exactement. Les experts en confidentialité affirment que rien n'empêche Apple de remplacer la base de données de CSAM par une autre. La nouvelle base de données pourrait identifier les militants des droits, les partisans de la liberté et tout ce qui ne soutient pas le récit d'un gouvernement. En bref, il pourrait être armé pour la surveillance.

Depuis son annonce, Apple est sous le feu des experts de la confidentialité du monde entier. La technologie est décrite comme une porte dérobée que les gouvernements autoritaires finiront par utiliser.

Alors qu'Apple s'engage à ne céder à aucune demande des gouvernements, l'existence même d'une telle technologie inquiète les experts. Les organisations de protection de la vie privée telles que Electronic Frontier Foundation (EFF) – y compris l'ex-dénonciateur de la CIA Edward Snowden – se sont prononcés à propos de cette décision. Et plus de 90 organisations de la société civile ont publié un lettre ouverte à Apple d'abandonner la sortie de sa technologie de détection de CSAM. L'annonce a également apparemment a suscité des critiques au sein d'Apple.

Fait intéressant, la même entreprise a déjà combattu le FBI et le tribunal fédéral contre la création d'un système d'exploitation personnalisé dans l'affaire San Bernadino de 2015. Apple a cité les raisons d'une mauvaise utilisation potentielle de la version personnalisée d'iOS qui peut contourner la sécurité de l'iPhone, l'appelant même "l'équivalent logiciel du cancer".

Apple craignait beaucoup de créer quelque chose qui pouvait être mal utilisé. Cependant, des années plus tard, Apple contredit apparemment sa propre position sur la vie privée. Alors qu'Apple continue de dire qu'une grande partie du scepticisme est due à la confusion entourant son fonctionnement, les experts en matière de confidentialité ont rejeté toute explication qu'Apple a publiée, y compris une document de modèle de menace qui explique comment le système est conçu pour gérer les interférences et les erreurs.

Le système de détection CSAM est à la fois appareil et cloud. Le système ne fonctionne pleinement que lorsque vous avez activé iCloud Photos. Le désactiver désactivera l'autre moitié du système, ce qui est nécessaire pour que les résultats détectés parviennent à Apple.

Il n'y a aucun moyen de désactiver l'analyse sur l'appareil. Et Apple a rendu le système tel

qu'il n'informe pas l'utilisateur si un CSAM est détecté sur l'appareil.

Le CSAM d'Apple comporte deux parties : iCloud et Messages.

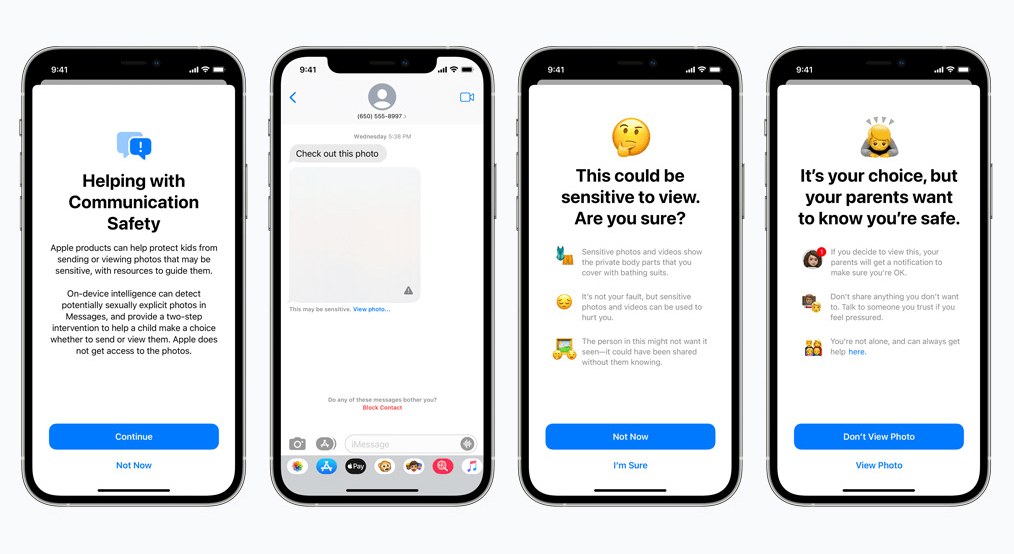

La sécurité des communications pour Messages fonctionne différemment de son homologue iCloud. Il utilise l'apprentissage automatique sur l'appareil pour identifier si un message entrant ou sortant contient des photos sexuellement explicites. Les parents pourront activer la fonctionnalité pour les enfants sur leur compte iCloud Family.

La photo sera floue si elle est de nature sexuellement explicite et marquée comme sensible. Si l'utilisateur continue à voir la photo malgré tout, le parent recevra une notification à ce sujet. Cela fonctionne également lorsqu'un enfant essaie d'envoyer une photo marquée comme sexuellement explicite.

Dans un développement récent, Apple a annoncé son intention de retarder le déploiement de CSAM jusqu'à plus tard.

En tant que défenseurs de la vie privée, nous croyons fermement que si des outils existent, ils peuvent être manipulés à des fins malveillantes. Il y a actuellement des milliards d'iPhones et d'iPads dans le monde ; la mise en œuvre d'une technologie qui peut être modifiée de manière coercitive pour répondre à un objectif par des gouvernements oppressifs est une possibilité réelle.

© Copyright 2024 VPN le plus rapide - Tous droits réservés.

Ne manquez pas cette offre, elle est livrée avec Password Manager GRATUITEMENT.

Ce site utilise des cookies afin que nous puissions vous offrir la meilleure expérience utilisateur possible. Les informations sur les cookies sont stockées dans votre navigateur et remplissent des fonctions telles que vous reconnaître lorsque vous revenez sur notre site Web et aider notre équipe à comprendre quelles sections du site Web vous trouvez les plus intéressantes et utiles.

Le cookie strictement nécessaire doit être activé à tout moment afin que nous puissions enregistrer vos préférences pour les paramètres de cookies.

Si vous désactivez ce cookie, nous ne pourrons pas enregistrer vos préférences. Cela signifie que chaque fois que vous visitez ce site, vous devrez activer ou désactiver à nouveau les cookies.