Obtenga 93% de descuento en Lifetime

Oferta exclusiva

No se pierda esta oferta, viene con Password Manager GRATIS.

Recibe 93% apagado en FastestVPN y aprovechar PaseHulk Administrador de contraseñas SIN COSTO

¡Consigue esta oferta ahora!By nick anderson Sin comentarios 6 minutos

Apple ha anunciado recientemente dos características que vendrán como parte de una futura actualización de iOS. Las dos características han recibido muchas críticas por parte de los defensores de la privacidad. Apple se mantiene firme en su convicción de que su enfoque no viola la privacidad de los usuarios.

Analicemos qué es el material de abuso sexual infantil (CSAM, por sus siglas en inglés) y cómo Apple lo está abordando, lo que provocó una reacción violenta de los expertos en privacidad de todo el mundo.

Material de abuso sexual infantil (CSAM) es cualquier cosa que contenga material sexual relacionado con niños menores de edad. La detección de MASI es una tecnología que encuentra dicho contenido comparándolo con una base de datos de MANI conocida.

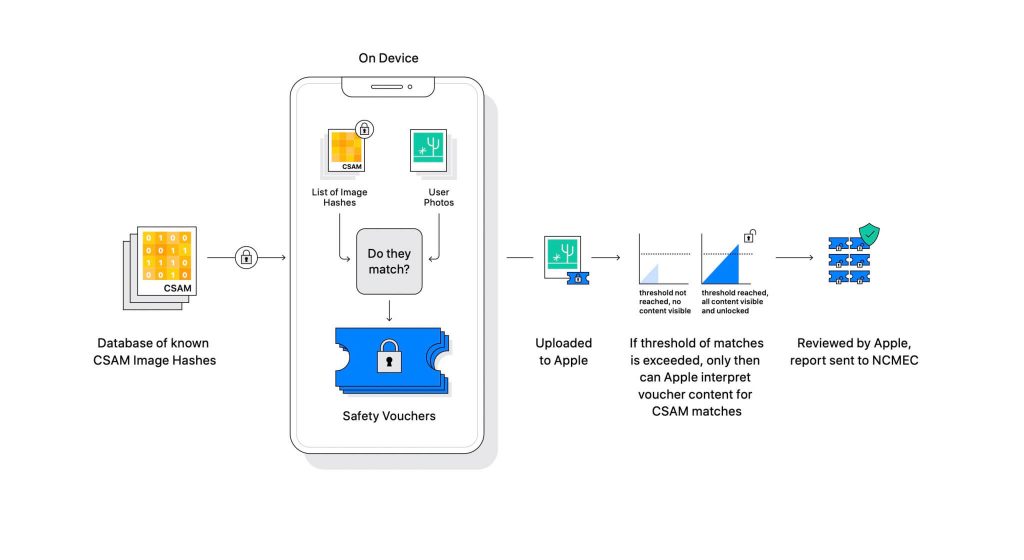

Apple reveló la tecnología como parte de una próxima actualización de software. Funciona comparando las fotos que los usuarios cargan en iCloud con una base de datos de CSAM conocida mantenida por el Centro Nacional para Niños Explotados Desaparecidos (NCMEC) y otras organizaciones de seguridad infantil. Pero escanear las imágenes sería una gran violación de la privacidad, por lo que, en cambio, la tecnología de Apple llamada NeuralHash compara los hashes de las imágenes con los hashes proporcionados por NCMEC.

La base de datos de hashes CSAM conocidos se almacenará en cada dispositivo. El proceso de coincidencia es de naturaleza completamente criptográfica. Apple dice que su tecnología de criptografía crea un comprobante seguro cuando se encuentra una coincidencia y almacena el resultado. La imagen y el cupón se cargan en iCloud si el usuario ha habilitado el uso compartido de fotos de iCloud.

Apple creó otro mecanismo que permite que el cupón permanezca seguro contra cualquier intervención, incluida la de Apple. Piense en ello como un candado que solo se abre una vez que llega a un número determinado.

(Créditos de la imagen: Apple)

Apple no puede ver la imagen que está almacenada en el comprobante criptográfico. Pero una vez que se cruza el umbral, Apple tomará una intervención manual. Esta parte es importante para asegurarse de que el sistema no ha producido un error. Alguien de Apple verificará manualmente la imagen y confirmará si realmente es CSAM. Si se determina que la imagen es CSAM, se eliminará la cuenta del usuario y se notificará a las agencias de aplicación de la ley sobre la persona.

Apple afirma que el umbral seleccionado ofrece una probabilidad de 1 en un billón de marcar incorrectamente una cuenta.

No se puede negar que el MASI es un gran problema. Cuando se creó el cifrado de extremo a extremo para reforzar la privacidad, también proporcionó seguridad a los depredadores frente a las fuerzas del orden. Pueden compartir dicho material y evadir la detección de las fuerzas del orden.

Una forma de evitarlo es escanear todas las imágenes que se cargan en los servicios en la nube, como Dropbox, OneDrive, Google Drive, iCloud. Sin embargo, Apple lideró un enfoque centrado en la privacidad que no implica el escaneo de las imágenes, sino hashes.

Un hash es un valor criptográfico de una entrada que se ha pasado a través de un algoritmo. El resultado será un valor hash exclusivo de la entrada, como una imagen. Entonces, en lugar de comparar las imágenes en sí, se pueden comparar sus valores hash para determinar si son las mismas imágenes o no.

Todo eso suena perfecto, ¿verdad? No exactamente. Los expertos en privacidad argumentan que nada impide que Apple reemplace la base de datos de CSAM por otra. La nueva base de datos podría identificar activistas de derechos, partidarios de la libertad y cualquier cosa que no respalde la narrativa de un gobierno. En resumen, podría armarse para la vigilancia.

Desde su anuncio, Apple ha estado bajo el fuego de los expertos en privacidad de todo el mundo. La tecnología se describe como una puerta trasera que los gobiernos autoritarios eventualmente usarán.

Si bien Apple se compromete a no ceder ante ninguna demanda de los gobiernos, la existencia misma de dicha tecnología preocupa a los expertos. Organizaciones de privacidad tales como Electronic Frontier Foundation (EFF), incluido el ex denunciante de la CIA Edward Snowden, han expresado su opinión sobre la medida. Y hasta más de 90 organizaciones de la sociedad civil han publicado un carta abierta a Apple para que abandone el lanzamiento de su tecnología de detección de CSAM. El anuncio también ha según se informa provocó críticas dentro de Apple.

Curiosamente, la misma empresa una vez luchó contra el FBI y la corte federal en contra de la creación de un sistema operativo personalizado en el caso de San Bernardino de 2015. Apple citó las razones del posible uso indebido de la versión personalizada de iOS que puede eludir la seguridad del iPhone, e incluso lo llamó "software equivalente al cáncer".

Apple estaba muy preocupado por crear algo que tuviera el potencial de ser mal utilizado. Sin embargo, años después, Apple parece contradecir su propia postura sobre la privacidad. Si bien Apple continúa diciendo que gran parte del escepticismo se debe a la confusión en torno a su funcionamiento, los expertos en privacidad han descartado cualquier explicación que haya emitido Apple, incluida una documento de modelo de amenaza que establece cómo el sistema está diseñado para manejar interferencias y errores.

El sistema de detección de CSAM es parte del dispositivo y parte de la nube. El sistema funciona completamente solo cuando tienes iCloud Photos activado. Apagarlo desactivará la otra mitad del sistema, que es necesaria para que los resultados detectados lleguen a Apple.

No hay forma de desactivar el escaneo en el dispositivo. Y Apple ha hecho que el sistema sea tan

que no notifique al usuario si se detecta un CSAM en el dispositivo.

Hay dos partes en el CSAM de Apple: iCloud y Messages.

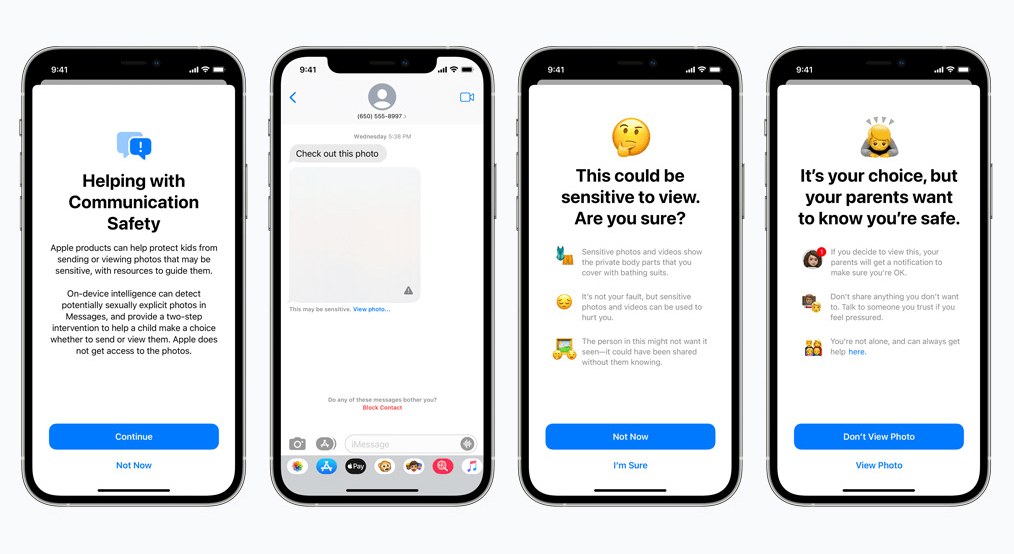

La seguridad de las comunicaciones para Mensajes funciona de manera diferente a su contraparte de iCloud. Utiliza el aprendizaje automático en el dispositivo para identificar si un mensaje entrante o saliente contiene fotos sexualmente explícitas. Los padres podrán habilitar la función para niños en su cuenta familiar de iCloud.

La foto se verá borrosa si es de naturaleza sexualmente explícita y se marcará como sensible. Si el usuario procede a ver la foto de todos modos, el padre recibirá una notificación al respecto. Esto también funciona cuando un niño intenta enviar una foto que ha sido marcada como sexualmente explícita.

En un desarrollo reciente, Apple anunció sus planes para retrasar el lanzamiento de CSAM hasta más adelante.

Nosotros, como defensores de la privacidad, creemos firmemente que, si existen herramientas, pueden manipularse con malos fines. Hay miles de millones de iPhones y iPads en el mundo ahora mismo; implementar una tecnología que pueda ser alterada coercitivamente para adaptarse a un propósito por parte de gobiernos opresivos es una posibilidad real.

Copyright © 2024 VPN más rápido - Todos los derechos reservados.

No se pierda esta oferta, viene con Password Manager GRATIS.

Este sitio web utiliza cookies para que podamos brindarle la mejor experiencia de usuario posible. La información de cookies se almacena en su navegador y realiza funciones tales como reconocerlo cuando regrese a nuestro sitio web y ayudar a nuestro equipo a comprender qué secciones del sitio web le resultan más interesantes y útiles.

La cookie estrictamente necesaria debe estar habilitada en todo momento para que podamos guardar sus preferencias para la configuración de cookies.

Si deshabilita esta cookie, no podremos guardar sus preferencias. Esto significa que cada vez que visite este sitio web deberá habilitar o deshabilitar nuevamente las cookies.