Få 93 % RABATT på Lifetime

Exklusivt erbjudande

Missa inte detta erbjudande, det kommer med Password Manager GRATIS.

Skaffa sig 93% av på FastestVPN och nytta PassHulk Password Manager FRI

Få det här erbjudandet nu!By Nick Andersson Inga kommentarer 6 minuter

Apple har nyligen meddelat två funktioner som kommer som en del av en framtida iOS-uppdatering. De två funktionerna har mötts av mycket kritik från integritetsförespråkare. Apple är fortfarande fast i sin övertygelse om att dess tillvägagångssätt inte kränker användarnas integritet.

Låt oss diskutera vad material för sexuellt övergrepp mot barn (CSAM) är och hur Apple hanterar det, vilket orsakar motreaktioner från integritetsexperter över hela världen.

Material för sexuella övergrepp mot barn (CSAM) är allt som innehåller sexuellt material relaterat till minderåriga barn. CSAM-detektering är en teknik som hittar sådant innehåll genom att matcha det mot en känd CSAM-databas.

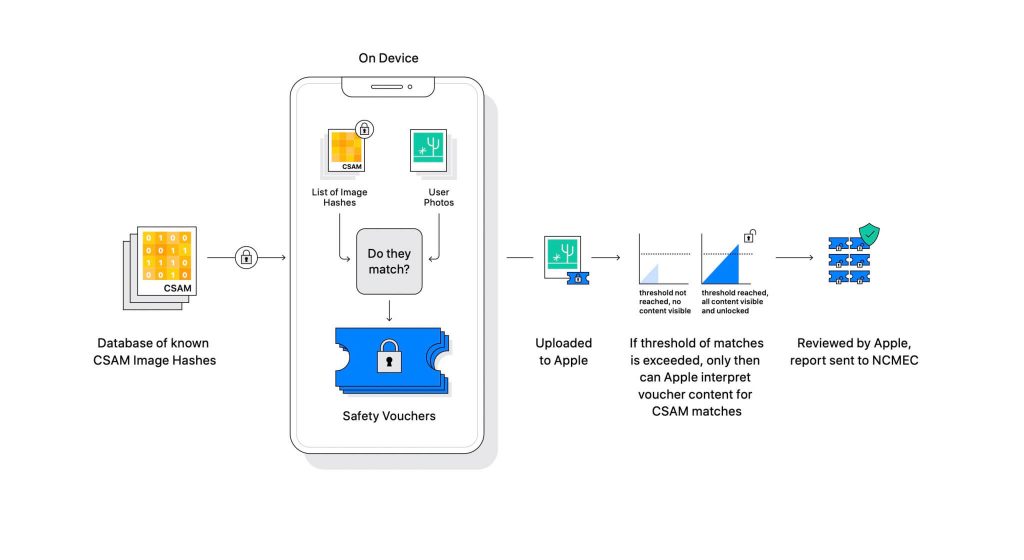

Apple avslöjade tekniken som en del av en kommande mjukvaruuppdatering. Det fungerar genom att jämföra de bilder som användare laddar upp på iCloud med en känd CSAM-databas som underhålls av National Center for Missing Exploited Children (NCMEC) och andra barnsäkerhetsorganisationer. Men att skanna bilderna skulle vara ett enormt intrång i integriteten, så istället matchar Apples teknik som heter NeuralHash hash av bilderna mot hash som tillhandahålls av NCMEC.

Databasen med kända CSAM-hashar kommer att lagras på varje enhet. Matchningsprocessen är helt kryptografisk till sin natur. Apple säger att dess kryptografiteknik skapar en säker voucher när en matchning hittas och lagrar resultatet. Bilden och vouchern laddas upp till iCloud om användaren har aktiverat iCloud-fotodelning.

Apple skapade en annan mekanism som gör att vouchern är säker mot alla ingrepp, inklusive Apples. Se det som ett lås som bara låses upp när det träffar ett visst nummer.

(Bildkrediter: Apple)

Apple kan inte se bilden som är lagrad i den kryptografiska verifikationen. Men när tröskeln har passerats kommer Apple att vidta en manuell intervention. Denna del är viktig för att säkerställa att systemet inte har skapat ett fel. Någon från Apple kommer manuellt att kontrollera bilden och bekräfta om det verkligen är CSAM. Om bilden visar sig vara CSAM kommer användarens konto att raderas och brottsbekämpande myndigheter kommer att meddelas om personen.

Apple uppger att den valda tröskeln ger en sannolikhet på 1 på en biljon för att felaktigt flagga ett konto.

Det går inte att förneka att CSAM är ett stort problem. När end-to-end-kryptering skapades för att stärka integriteten, gav det också rovdjurssäkerhet från brottsbekämpande myndigheter. De kan dela sådant material och undvika upptäckt av brottsbekämpande myndigheter.

Ett sätt att förhindra det är att skanna alla bilder som laddas upp till molntjänster, som Dropbox, OneDrive, Google Drive, iCloud. Apple ledde dock ett integritetsfokuserat tillvägagångssätt som inte involverar skanning av bilderna utan istället hash.

En hash är ett kryptografiskt värde för en indata som har passerats genom en algoritm. Resultatet blir ett hashvärde som är unikt för indata, till exempel en bild. Så istället för att jämföra bilderna själva kan deras hashvärden jämföras för att avgöra om de är samma bilder eller inte.

Allt det där låter perfekt, eller hur? Inte exakt. Sekretessexperter hävdar att ingenting hindrar Apple från att ersätta databasen med CSAM med en annan. Den nya databasen kan identifiera rättighetsaktivister, frihetsanhängare och allt som inte stödjer en regerings berättelse. Kort sagt, det kan vara vapen för övervakning.

Sedan tillkännagivandet har Apple varit under beskjutning från integritetsexperter över hela världen. Tekniken beskrivs som en bakdörr som auktoritära regeringar så småningom kommer att använda.

Även om Apple förbinder sig att inte ge efter för några krav från regeringar, har själva existensen av sådan teknik fått experterna att oroa sig. Integritetsorganisationer som t.ex Electronic Frontier Foundation (EFF) – inklusive ex-CIA whistleblower Edward Snowden – har varit högljudda om flytten. Och så många som 90+ civilsamhällesorganisationer har släppt en öppet brev till Apple att överge lanseringen av sin CSAM-detektionsteknik. Tillkännagivandet har också enligt uppgift väckte kritik inom Apple.

Intressant nog kämpade samma företag en gång FBI och den federala domstolen mot att skapa ett anpassat OS i San Bernadino-fallet 2015. Apple citerade orsaker till potentiellt missbruk av den anpassade iOS-versionen som kan kringgå iPhones säkerhet, och kallar den till och med "programvara som motsvarar cancer."

Apple var mycket orolig för att skapa något som hade potential för missbruk. Men flera år på vägen motsäger Apple till synes sin egen hållning om integritet. Medan Apple fortsätter att säga att mycket av skepsisen beror på förvirring kring hur det fungerar, har integritetsexperter avfärdat alla förklaringar som Apple har utfärdat, inklusive en hotmodelldokument som beskriver hur systemet är designat för att hantera störningar och fel.

CSAM-detektionssystem är delvis enhet och delvis moln. Systemet fungerar endast fullt ut när du har aktiverat iCloud Photos. Om du stänger av den inaktiveras den andra halvan av systemet, vilket är nödvändigt för att de upptäckta resultaten ska nå Apple.

Det finns inget sätt att stänga av skanningen på enheten. Och Apple har gjort systemet sådant

att den inte meddelar användaren om en CSAM upptäcks på enheten.

Det finns två delar till Apples CSAM: iCloud och meddelanden.

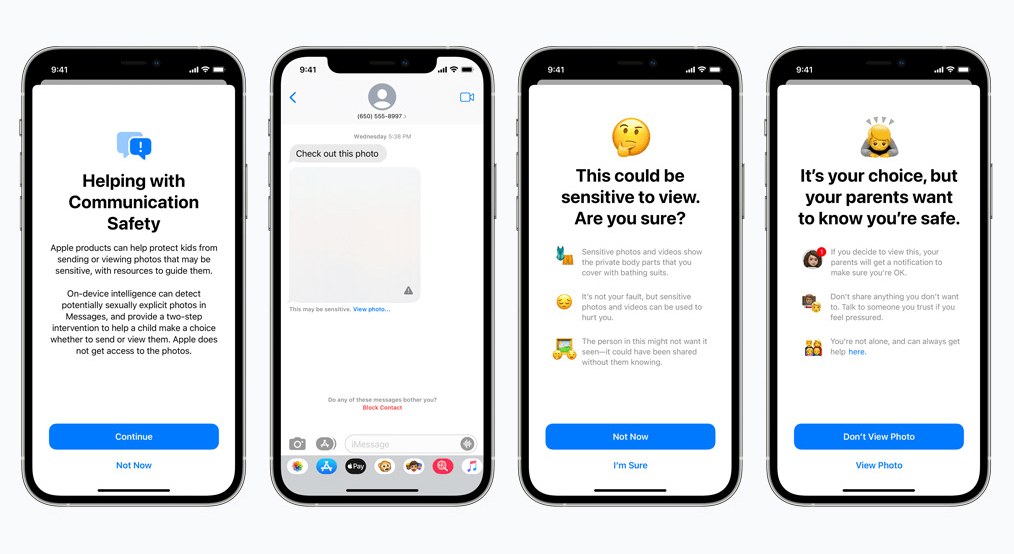

Kommunikationssäkerhet för meddelanden fungerar annorlunda än sin iCloud-motsvarighet. Den använder maskininlärning på enheten för att identifiera om ett inkommande eller utgående meddelande innehåller sexuellt explicita foton. Föräldrar kommer att kunna aktivera funktionen för barn på deras iCloud Family-konto.

Fotot blir suddigt om det är sexuellt explicit och markerat som känsligt. Om användaren ändå fortsätter att se fotot kommer föräldern att få ett meddelande om det. Detta fungerar också när ett barn försöker skicka ett foto som har markerats som sexuellt explicit.

I en ny utveckling tillkännagav Apple sina planer på att skjuta upp lanseringen av CSAM till senare.

Vi, som integritetsförespråkare, tror starkt på att om verktyg finns kan de manipuleras i dåliga syften. Det finns miljarder iPhones och iPads i världen just nu; att implementera en teknik som med tvång kan ändras för att passa ett syfte av förtryckande regeringar är en verklig möjlighet.

© Copyright 2024 Snabbaste VPN - All Rights Reserved.

Missa inte detta erbjudande, det kommer med Password Manager GRATIS.

Den här webbplatsen använder cookies så att vi kan ge dig den bästa användarupplevelsen som är möjlig. Cookieinformation lagras i din webbläsare och utför funktioner som att känna igen dig när du återvänder till vår webbplats och hjälper vårt team att förstå vilka delar av webbplatsen som du tycker är mest intressanta och användbara.

Strikt nödvändig cookie ska alltid vara aktiverad så att vi kan spara dina inställningar för cookie-inställningar.

Om du inaktiverar den här cookien kan vi inte spara dina inställningar. Det innebär att varje gång du besöker denna webbplats måste du aktivera eller inaktivera cookies igen.