Получите СКИДКУ 93% на всю жизнь

Эксклюзивное предложение

Не пропустите эту сделку, она поставляется с Менеджером паролей БЕСПЛАТНО.

Получить 93% выкл на FastestVPN и пользу ПасХалк Менеджер паролей бесплатно

Получить эту сделку сейчас!By Ник Андерсон Без комментариев 6 минут

Недавно Apple объявила о двух функциях, которые станут частью будущего обновления iOS. Эти две функции были встречены большой критикой со стороны защитников конфиденциальности. Apple по-прежнему твердо убеждена, что ее подход не нарушает конфиденциальность пользователей.

Давайте обсудим, что такое материалы о сексуальном насилии над детьми (CSAM) и как Apple борется с этим, что вызывает негативную реакцию экспертов по конфиденциальности во всем мире.

Материалы сексуального насилия над детьми (CSAM) — это все, что содержит материалы сексуального характера, касающиеся несовершеннолетних детей. Обнаружение CSAM — это технология, которая находит такой контент, сопоставляя его с известной базой данных CSAM.

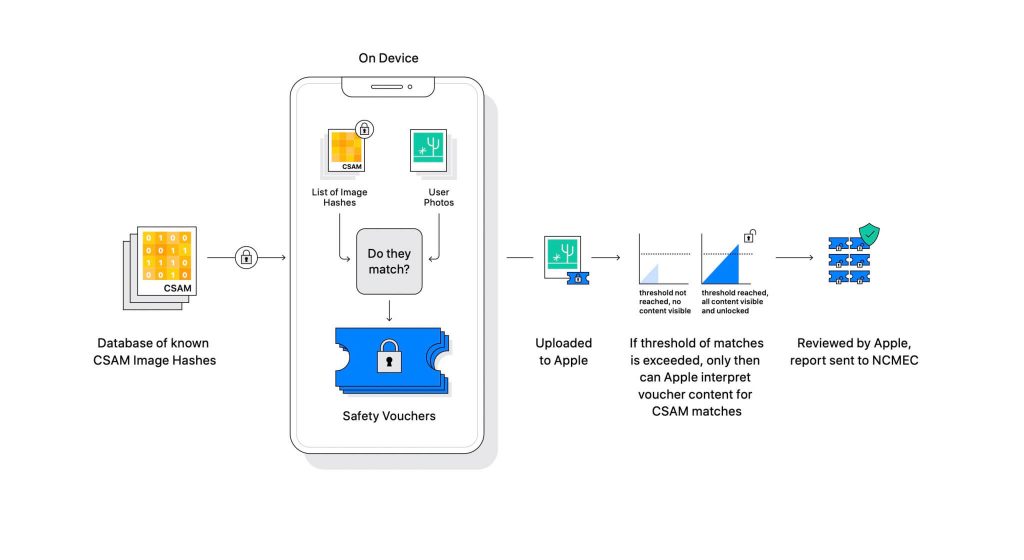

Apple представила эту технологию как часть предстоящего обновления программного обеспечения. Он работает путем сравнения фотографий, загруженных пользователями в iCloud, с известной базой данных CSAM, которую ведет Национальный центр пропавших без вести эксплуатируемых детей (NCMEC) и другие организации по безопасности детей. Но сканирование изображений было бы огромным нарушением конфиденциальности, поэтому вместо этого технология Apple под названием NeuralHash сопоставляет хэши изображений с хэшами, предоставленными NCMEC.

База данных известных хэшей CSAM будет храниться на каждом устройстве. Процесс сопоставления носит полностью криптографический характер. Apple говорит, что ее криптографическая технология создает безопасный ваучер при обнаружении совпадения и сохраняет результат. Изображение и ваучер загружаются в iCloud, если пользователь включил общий доступ к фотографиям iCloud.

Apple создала еще один механизм, который позволяет защитить ваучер от любого вмешательства, в том числе со стороны Apple. Думайте об этом как о замке, который открывается только после того, как он наберет определенное число.

(Изображение предоставлено Apple)

Apple не видит изображение, хранящееся в криптографическом ваучере. Но как только порог будет преодолен, Apple вмешается вручную. Эта часть важна для того, чтобы система не выдала ошибку. Кто-то из Apple вручную проверит изображение и подтвердит, действительно ли это CSAM. Если изображение окажется CSAM, учетная запись пользователя будет удалена, а правоохранительные органы будут уведомлены о человеке.

Apple заявляет, что выбранный порог обеспечивает вероятность неправильной пометки учетной записи 1 из триллиона.

Нельзя отрицать, что CSAM представляет собой огромную проблему. Когда сквозное шифрование было создано для защиты конфиденциальности, оно также обеспечило защиту злоумышленников от правоохранительных органов. Они могут поделиться такими материалами и избежать обнаружения правоохранительными органами.

Один из способов предотвратить это — сканировать все изображения, загружаемые в облачные сервисы, такие как Dropbox, OneDrive, Google Drive, iCloud. Однако Apple придерживается подхода, ориентированного на конфиденциальность, который включает сканирование не изображений, а хэшей.

Хэш — это криптографическое значение ввода, которое было передано через алгоритм. Результатом будет хеш-значение, уникальное для входных данных, таких как изображение. Таким образом, вместо того, чтобы сравнивать сами изображения, можно сравнить их хеш-значения, чтобы определить, являются ли они одними и теми же изображениями или нет.

Все это звучит идеально, правда? Не совсем. Эксперты по конфиденциальности утверждают, что ничто не мешает Apple заменить базу данных CSAM на другую. Новая база данных может идентифицировать правозащитников, сторонников свободы и всех, кто не поддерживает повествование правительства. Короче говоря, его можно было использовать для наблюдения.

С момента своего объявления Apple подверглась критике со стороны экспертов по конфиденциальности со всего мира. Эта технология описывается как черный ход, который в конечном итоге будут использовать авторитарные правительства.

Хотя Apple заявляет, что не уступит никаким требованиям правительств, само существование такой технологии беспокоит экспертов. Организации конфиденциальности, такие как Electronic Frontier Foundation (EFF), в том числе бывший разоблачитель ЦРУ Эдвард Сноуден, открыто заявили об этом шаге. И более 90 организаций гражданского общества выпустили Открой письмо Apple отказаться от выпуска своей технологии обнаружения CSAM. В объявлении также , по имеющимся данным вызвало критику внутри Apple.

Интересно, что эта же компания когда-то боролась с ФБР и федеральным судом против создания пользовательской ОС в деле Сан-Бернардино в 2015 году. Apple назвала причины потенциального неправомерного использования пользовательской версии iOS, которая может обойти защиту iPhone, даже назвав ее «программным эквивалентом рака».

Apple очень опасалась создавать что-то, что могло быть использовано не по назначению. Однако спустя годы Apple, похоже, противоречит своей собственной позиции в отношении конфиденциальности. В то время как Apple продолжает говорить, что большая часть скептицизма вызвана путаницей в отношении того, как это работает, эксперты по конфиденциальности отклонили любые объяснения Apple, в том числе документ модели угрозы в нем показано, как система предназначена для обработки помех и ошибок.

Система обнаружения CSAM является частью устройства и частью облака. Система работает полноценно только при включенном iCloud Photos. Его отключение отключит другую половину системы, что необходимо для того, чтобы обнаруженные результаты достигли Apple.

Отключить сканирование на устройстве невозможно. И Apple сделала систему такой

что он не уведомляет пользователя, если на устройстве обнаружен CSAM.

CSAM от Apple состоит из двух частей: iCloud и Messages.

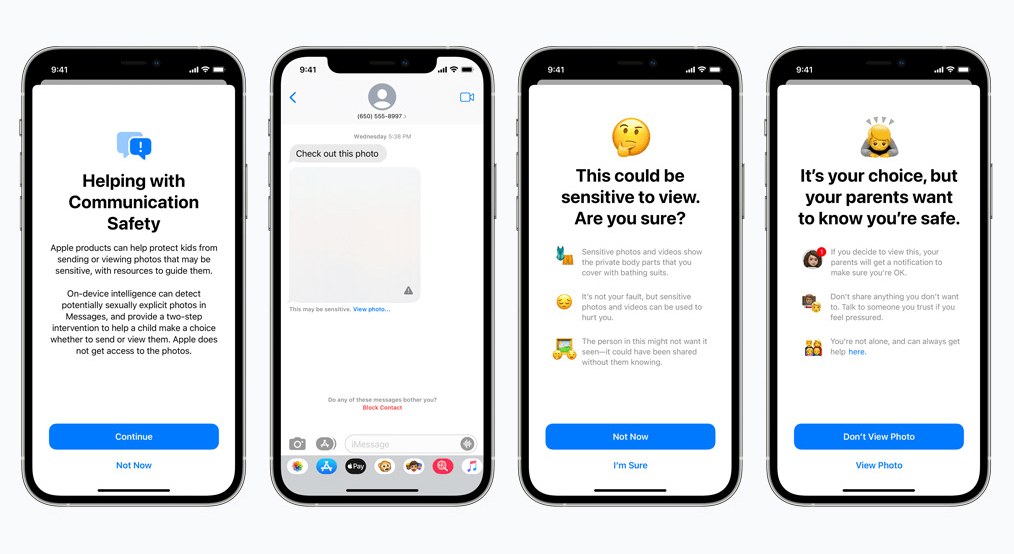

Безопасность связи для сообщений работает иначе, чем ее аналог iCloud. Он использует машинное обучение на устройстве, чтобы определить, содержит ли входящее или исходящее сообщение фотографии сексуального характера. Родители смогут включить эту функцию для детей в своей учетной записи iCloud Family.

Фотография будет размыта, если она носит откровенно сексуальный характер и помечена как чувствительная. Если пользователь все равно перейдет к просмотру фотографии, родитель получит уведомление об этом. Это также работает, когда ребенок пытается отправить фотографию, которая помечена как откровенно сексуальная.

Недавно Apple объявила о своих планах отложить развертывание CSAM на более поздний срок.

Мы, как защитники конфиденциальности, твердо верим, что если инструменты существуют, ими можно манипулировать в злых целях. Сейчас в мире миллиарды iPhone и iPad; внедрение технологии, которая может быть принудительно изменена репрессивными правительствами в соответствии с целью, является реальной возможностью.

© Copyright 2024 Самый быстрый впн - Все права защищены.

Не пропустите эту сделку, она поставляется с Менеджером паролей БЕСПЛАТНО.

На этом веб-сайте используются файлы cookie, чтобы мы могли предоставить вам наилучшие возможности для пользователей. Информация о файлах cookie хранится в вашем браузере и выполняет такие функции, как распознавание вас, когда вы возвращаетесь на наш сайт, и помогаете нашей команде понять, какие разделы веб-сайта вы найдете наиболее интересными и полезными.

Строго необходимое Cookie должно быть включено всегда, чтобы мы могли сохранить ваши настройки для настроек cookie.

Если вы отключите этот файл cookie, мы не сможем сохранить ваши предпочтения. Это означает, что каждый раз, когда вы посещаете этот сайт, вам нужно снова включить или отключить файлы cookie.