Ganhe 93% de desconto no Lifetime

Oferta exclusiva

Não perca esta oferta, ela vem com o Gerenciador de Senhas GRATUITO.

Get 93% desligado em FastestVPN e aproveitar PassHulkName Password Manager GRATUITA

Obtenha este negócio agora!By Nick Anderson Sem comentários 6 minutos

A Apple anunciou recentemente dois recursos que farão parte de uma futura atualização do iOS. Os dois recursos receberam muitas críticas dos defensores da privacidade. A Apple permanece firme em sua convicção de que sua abordagem não viola a privacidade dos usuários.

Vamos discutir o que é Material de Abuso Sexual Infantil (CSAM) e como a Apple está lidando com isso, causando reação de especialistas em privacidade em todo o mundo.

Material de abuso sexual infantil (CSAM) é qualquer coisa que contenha material sexual relacionado a crianças menores de idade. A detecção de CSAM é uma tecnologia que encontra esse conteúdo comparando-o com um banco de dados de CSAM conhecido.

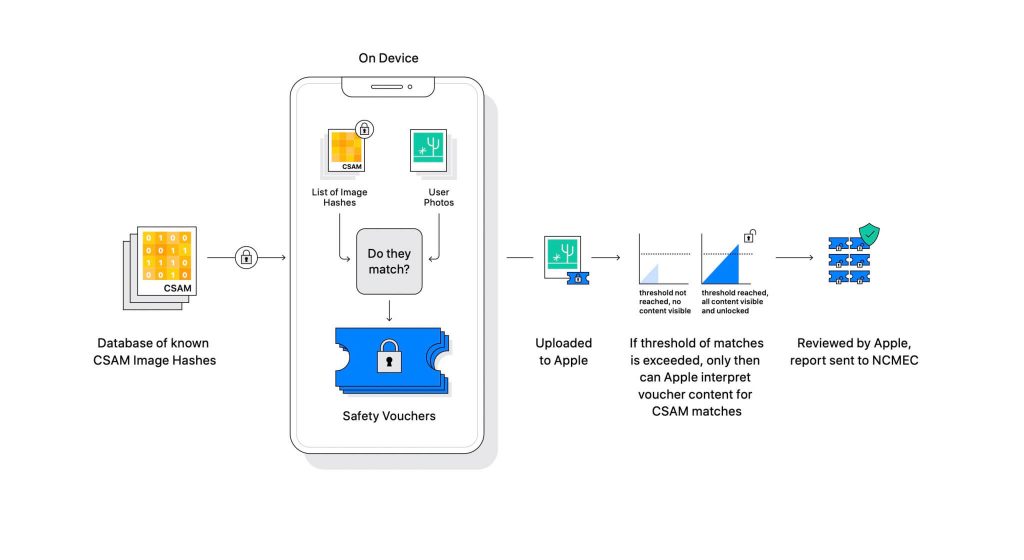

A Apple revelou a tecnologia como parte de uma próxima atualização de software. Ele funciona comparando as fotos que os usuários carregam no iCloud com um banco de dados CSAM conhecido mantido pelo Centro Nacional para Crianças Desaparecidas Exploradas (NCMEC) e outras organizações de segurança infantil. Mas digitalizar as imagens seria uma grande violação de privacidade, então, em vez disso, a tecnologia da Apple chamada NeuralHash compara os hashes das imagens com os hashes fornecidos pelo NCMEC.

O banco de dados de hashes CSAM conhecidos será armazenado em todos os dispositivos. O processo de correspondência é completamente criptográfico por natureza. A Apple diz que sua tecnologia de criptografia cria um voucher seguro quando uma correspondência é encontrada e armazena o resultado. A imagem e o comprovante são carregados no iCloud se o usuário tiver ativado o compartilhamento de fotos do iCloud.

A Apple criou outro mecanismo que permite que o voucher permaneça seguro contra qualquer intervenção, inclusive da Apple. Pense nisso como um cadeado que só é desbloqueado quando atinge um determinado número.

(Créditos da imagem: Apple)

A Apple não pode ver a imagem armazenada no comprovante criptográfico. Mas assim que o limite for ultrapassado, a Apple fará uma intervenção manual. Esta parte é importante para garantir que o sistema não tenha produzido um erro. Alguém da Apple verificará manualmente a imagem e confirmará se realmente é CSAM. Se for descoberto que a imagem é CSAM, a conta do usuário será excluída e as agências de aplicação da lei serão notificadas sobre a pessoa.

A Apple afirma que o limite selecionado oferece uma probabilidade de 1 em um trilhão para sinalizar incorretamente uma conta.

Não há como negar que o CSAM é um grande problema. Quando a criptografia de ponta a ponta foi criada para reforçar a privacidade, ela também forneceu proteção aos predadores contra a aplicação da lei. Eles podem compartilhar esse material e evitar a detecção da aplicação da lei.

Uma maneira de evitar isso é verificar todas as imagens enviadas para serviços em nuvem, como Dropbox, OneDrive, Google Drive, iCloud. No entanto, a Apple liderou uma abordagem focada na privacidade que não envolve a digitalização das imagens, mas sim hashes.

Um hash é um valor criptográfico de uma entrada que passou por um algoritmo. O resultado será um valor de hash exclusivo da entrada, como uma imagem. Portanto, em vez de comparar as próprias imagens, seus valores de hash podem ser comparados para determinar se são as mesmas imagens ou não.

Tudo isso parece perfeito, certo? Não exatamente. Especialistas em privacidade argumentam que nada impede a Apple de substituir o banco de dados do CSAM por outro. O novo banco de dados pode identificar ativistas de direitos, defensores da liberdade e qualquer coisa que não apoie a narrativa de um governo. Em suma, poderia ser armada para vigilância.

Desde o seu anúncio, a Apple tem sido criticada por especialistas em privacidade em todo o mundo. A tecnologia está sendo descrita como uma porta dos fundos que os governos autoritários acabarão usando.

Embora a Apple se comprometa a não ceder a nenhuma exigência dos governos, a própria existência dessa tecnologia preocupa os especialistas. Organizações de privacidade, como Electronic Frontier Foundation (EFF) – incluindo o ex-denunciante da CIA Edward Snowden – têm falado sobre a mudança. E mais de 90 organizações da sociedade civil lançaram um carta aberta para a Apple abandonar o lançamento de sua tecnologia de detecção de CSAM. O anúncio também alegadamente gerou críticas dentro da Apple.

Curiosamente, a mesma empresa uma vez lutou contra o FBI e o tribunal federal contra a criação de um sistema operacional personalizado no caso de San Bernardino em 2015. A Apple citou motivos de potencial uso indevido da versão personalizada do iOS que pode burlar a segurança do iPhone, chamando-o de “software equivalente ao câncer”.

A Apple estava muito apreensiva em criar algo que tivesse potencial para uso indevido. No entanto, anos depois, a Apple aparentemente está contradizendo sua própria posição sobre privacidade. Embora a Apple continue a dizer que grande parte do ceticismo se deve à confusão em torno de como funciona, especialistas em privacidade rejeitaram qualquer explicação que a Apple tenha emitido, incluindo um documento de modelo de ameaça que define como o sistema foi projetado para lidar com interferências e erros.

O sistema de detecção de CSAM é parte dispositivo e parte nuvem. O sistema funciona totalmente apenas quando você tem o iCloud Photos ativado. Desligá-lo desativará a outra metade do sistema, necessária para que os resultados detectados cheguem à Apple.

Não há como desativar a verificação no dispositivo. E a Apple tornou o sistema tão

que não notifique o usuário se um CSAM for detectado no dispositivo.

Existem duas partes no CSAM da Apple: iCloud e Mensagens.

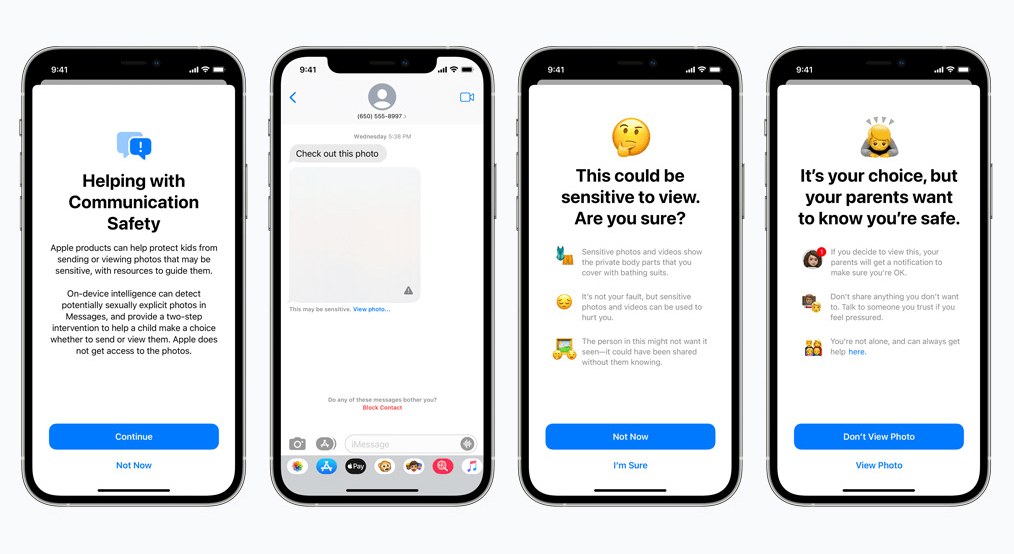

A segurança das comunicações para Mensagens funciona de maneira diferente de sua contraparte do iCloud. Ele usa aprendizado de máquina no dispositivo para identificar se uma mensagem recebida ou enviada contém fotos sexualmente explícitas. Os pais poderão ativar o recurso para crianças em sua conta iCloud Family.

A foto ficará desfocada se for de natureza sexualmente explícita e marcada como sensível. Se o usuário continuar visualizando a foto de qualquer maneira, o pai receberá uma notificação sobre isso. Isso também funciona quando uma criança está tentando enviar uma foto marcada como sexualmente explícita.

Em um desenvolvimento recente, a Apple anunciou seus planos de adiar o lançamento do CSAM para mais tarde.

Nós, como defensores da privacidade, acreditamos firmemente que, se existirem ferramentas, elas podem ser manipuladas para fins nocivos. Existem bilhões de iPhones e iPads no mundo agora; implementar uma tecnologia que pode ser alterada coercivamente para atender a um propósito de governos opressores é uma possibilidade real.

© de Copyright 2024 VPN mais rápida - Todos os direitos reservados.

Não perca esta oferta, ela vem com o Gerenciador de Senhas GRATUITO.

Este site usa cookies para que possamos fornecer a melhor experiência possível para o usuário. As informações dos cookies são armazenadas no seu navegador e executam funções como reconhecê-lo quando você retorna ao nosso site e ajudar a nossa equipe a entender quais seções do site você considera mais interessantes e úteis.

Cookies estritamente necessários devem estar sempre ativados para que possamos salvar suas preferências para configurações de cookies.

Se você desativar este cookie, não poderemos salvar suas preferências. Isso significa que toda vez que você visitar este site, será necessário ativar ou desativar os cookies novamente.