Uzyskaj 93% ZNIŻKI na całe życie

Ekskluzywna oferta

Nie przegap tej oferty, zawiera Menedżera haseł BEZPŁATNIE.

Get 93% Wyłącz włącz FastestVPN i skorzystaj PrzełęczHulk Password Manager DARMOWE

Zdobądź tę ofertę teraz!By Nicka Andersona Bez komentarza 6 minut

Firma Apple ogłosiła niedawno dwie funkcje, które pojawią się w ramach przyszłej aktualizacji systemu iOS. Te dwie funkcje spotkały się z dużą krytyką ze strony obrońców prywatności. Apple pozostaje w przekonaniu, że jego podejście nie narusza prywatności użytkowników.

Porozmawiajmy o tym, czym są materiały związane z wykorzystywaniem seksualnym dzieci (CSAM) i jak Apple sobie z nimi radzi, wywołując sprzeciw ekspertów ds. prywatności na całym świecie.

Materiały związane z wykorzystywaniem seksualnym dzieci (CSAM) to wszystko, co zawiera materiały seksualne dotyczące nieletnich dzieci. Wykrywanie CSAM to technologia, która wyszukuje takie treści, dopasowując je do znanej bazy danych CSAM.

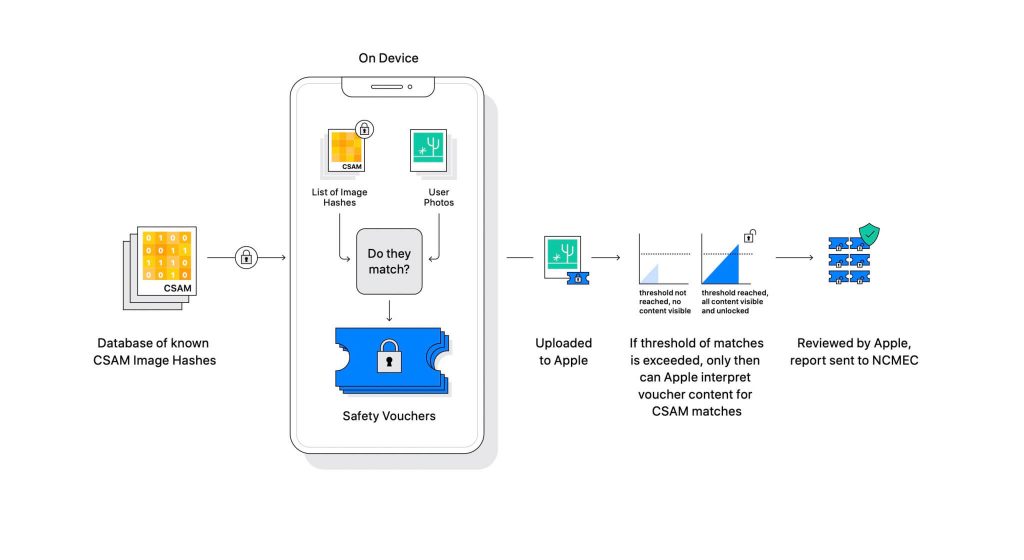

Firma Apple ujawniła tę technologię w ramach nadchodzącej aktualizacji oprogramowania. Działa poprzez porównanie zdjęć przesłanych przez użytkowników do iCloud ze znaną bazą danych CSAM prowadzoną przez National Center for Missing Exploited Children (NCMEC) i inne organizacje zajmujące się bezpieczeństwem dzieci. Ale skanowanie zdjęć byłoby ogromnym naruszeniem prywatności, więc zamiast tego technologia Apple o nazwie NeuralHash dopasowuje skróty obrazów do skrótów dostarczonych przez NCMEC.

Baza danych znanych skrótów CSAM będzie przechowywana na każdym urządzeniu. Proces dopasowywania ma charakter całkowicie kryptograficzny. Apple twierdzi, że jego technologia kryptograficzna tworzy bezpieczny kupon po znalezieniu dopasowania i przechowuje wynik. Obraz i kupon zostaną przesłane do iCloud, jeśli użytkownik włączył udostępnianie zdjęć iCloud.

Apple stworzył inny mechanizm, który pozwala zabezpieczyć kupon przed jakąkolwiek interwencją, w tym Apple. Pomyśl o tym jak o zamku, który odblokowuje się dopiero po osiągnięciu określonej liczby.

(Źródła obrazu: Apple)

Firma Apple nie widzi obrazu przechowywanego w kuponie kryptograficznym. Ale po przekroczeniu progu Apple podejmie ręczną interwencję. Ta część jest ważna, aby upewnić się, że system nie spowodował błędu. Ktoś z Apple ręcznie sprawdzi obraz i potwierdzi, czy to naprawdę CSAM. Jeśli obraz zostanie uznany za CSAM, konto użytkownika zostanie usunięte, a organy ścigania zostaną powiadomione o osobie.

Apple twierdzi, że wybrany próg zapewnia prawdopodobieństwo 1 na bilion nieprawidłowego oznaczenia konta.

Nie da się ukryć, że CSAM to ogromny problem. Gdy stworzono kompleksowe szyfrowanie w celu zwiększenia prywatności, zapewniło to również drapieżnikom ochronę przed organami ścigania. Mogą udostępniać takie materiały i unikać wykrycia przez organy ścigania.

Jednym ze sposobów zapobiegania temu jest skanowanie wszystkich obrazów przesyłanych do usług w chmurze, takich jak Dropbox, OneDrive, Google Drive, iCloud. Jednak Apple zastosował podejście skoncentrowane na prywatności, które nie obejmuje skanowania obrazów, ale zamiast tego hasze.

Hash to wartość kryptograficzna danych wejściowych, które zostały przekazane przez algorytm. Wynikiem będzie wartość skrótu, która jest unikalna dla danych wejściowych, na przykład obraz. Zamiast więc porównywać same obrazy, można porównać ich wartości skrótu, aby określić, czy są to te same obrazy, czy nie.

Wszystko to brzmi idealnie, prawda? Nie dokładnie. Eksperci ds. prywatności przekonują, że nic nie stoi na przeszkodzie, aby Apple wymienił bazę danych CSAM na inną. Nowa baza danych może zidentyfikować działaczy na rzecz praw człowieka, zwolenników wolności i wszystko, co nie wspiera narracji rządu. Krótko mówiąc, można go uzbroić w celu inwigilacji.

Od czasu ogłoszenia Apple jest pod ostrzałem ekspertów ds. prywatności na całym świecie. Technologia jest opisywana jako backdoor, z którego ostatecznie skorzystają autorytarne rządy.

Podczas gdy Apple zobowiązuje się, że nie ustąpi żadnym żądaniom ze strony rządów, samo istnienie takiej technologii niepokoi ekspertów. Organizacje zajmujące się ochroną prywatności, takie jak Electronic Frontier Foundation (EFF) – w tym były demaskator CIA Edward Snowden – głośno wypowiadali się na temat tego posunięcia. A ponad 90 organizacji społeczeństwa obywatelskiego wydało dokument List otwarty do Apple, aby zrezygnował z wydania swojej technologii wykrywania CSAM. Ogłoszenie również podobno wywołał krytykę w Apple.

Co ciekawe, ta sama firma walczyła kiedyś z FBI i sądem federalnym przeciwko stworzeniu niestandardowego systemu operacyjnego w sprawie San Bernadino z 2015 roku. Apple podał powody potencjalnego niewłaściwego użycia niestandardowej wersji iOS, która może ominąć zabezpieczenia iPhone'a, nazywając ją nawet „programowym odpowiednikiem raka”.

Apple bardzo obawiało się stworzenia czegoś, co mogłoby potencjalnie nadużyć. Jednak po latach Apple najwyraźniej zaprzecza własnemu stanowisku w sprawie prywatności. Podczas gdy Apple nadal twierdzi, że większość sceptycyzmu wynika z zamieszania wokół tego, jak to działa, eksperci ds. dokument modelu zagrożenia który określa, w jaki sposób system jest zaprojektowany do obsługi zakłóceń i błędów.

System wykrywania CSAM jest częściowo urządzeniem, a częściowo chmurą. System działa w pełni tylko wtedy, gdy masz włączone Zdjęcia iCloud. Wyłączenie go spowoduje wyłączenie drugiej połowy systemu, która jest niezbędna, aby wykryte wyniki dotarły do Apple.

Nie ma możliwości wyłączenia skanowania na urządzeniu. I Apple stworzyło taki system

że nie powiadamia użytkownika o wykryciu CSAM na urządzeniu.

CSAM firmy Apple składa się z dwóch części: iCloud i Wiadomości.

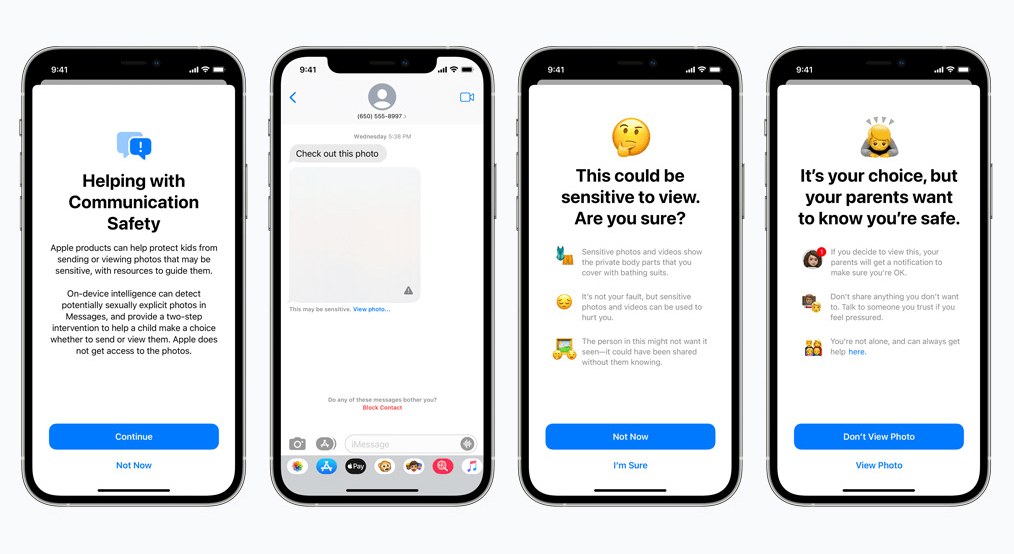

Bezpieczeństwo komunikacji dla Wiadomości działa inaczej niż jego odpowiednik iCloud. Korzysta z uczenia maszynowego na urządzeniu, aby określić, czy wiadomość przychodząca lub wychodząca zawiera zdjęcia o charakterze jednoznacznie seksualnym. Rodzice będą mogli włączyć tę funkcję dla dzieci na swoim koncie iCloud Family.

Zdjęcie zostanie rozmyte, jeśli ma charakter jednoznacznie seksualny i jest oznaczone jako drażliwe. Jeśli mimo to użytkownik przejdzie do przeglądania zdjęcia, rodzic otrzyma o tym powiadomienie. Działa to również wtedy, gdy dziecko próbuje wysłać zdjęcie, które zostało oznaczone jako jednoznacznie seksualne.

W niedawnym rozwoju firma Apple ogłosiła plany opóźnienia wprowadzenia CSAM na później.

My, obrońcy prywatności, mocno wierzymy, że jeśli istnieją narzędzia, można nimi manipulować w złych celach. Obecnie na świecie są miliardy iPhone'ów i iPadów; realną możliwością jest wdrożenie technologii, która może być przymusowo zmieniona, aby pasowała do celu przez opresyjne rządy.

© Copyright 2024 Najszybsza sieć VPN - Wszelkie prawa zastrzeżone.

Nie przegap tej oferty, zawiera Menedżera haseł BEZPŁATNIE.

Ta strona korzysta z plików cookie, abyśmy mogli zapewnić Ci najlepszą możliwą obsługę. Informacje o plikach cookie są przechowywane w przeglądarce użytkownika i służą do wykonywania funkcji, takich jak rozpoznawanie użytkownika po powrocie do naszej witryny i pomaganie naszemu zespołowi w zrozumieniu, które sekcje witryny są dla niego najbardziej interesujące i użyteczne.

Ściśle niezbędne pliki cookie powinny być włączone przez cały czas, abyśmy mogli zapisać preferencje dotyczące ustawień plików cookie.

Jeśli wyłączysz ten plik cookie, nie będziemy mogli zapisać Twoich preferencji. Oznacza to, że za każdym razem, gdy odwiedzasz tę stronę, musisz ponownie włączyć lub wyłączyć pliki cookie.