Krijg 93% KORTING op Lifetime

Exclusieve deal

Mis deze deal niet, hij wordt GRATIS geleverd met Password Manager.

Krijgen 93% uit aan FastestVPN en baten Pass Hulk Password Manager FREE

Profiteer nu van deze deal!By Nick Anderson Geen reacties 6 minuten

Apple heeft onlangs twee functies aangekondigd die deel zullen uitmaken van een toekomstige iOS-update. De twee functies hebben veel kritiek gekregen van voorstanders van privacy. Apple blijft er vast van overtuigd dat zijn aanpak de privacy van gebruikers niet schendt.

Laten we het hebben over wat materiaal over seksueel misbruik van kinderen (CSAM) is en hoe Apple dit aanpakt, wat weerslag veroorzaakte van privacy-experts over de hele wereld.

Materiaal met seksueel misbruik van kinderen (CSAM) is alles dat seksueel materiaal bevat dat betrekking heeft op minderjarige kinderen. CSAM-detectie is een technologie die dergelijke inhoud vindt door deze te vergelijken met een bekende CSAM-database.

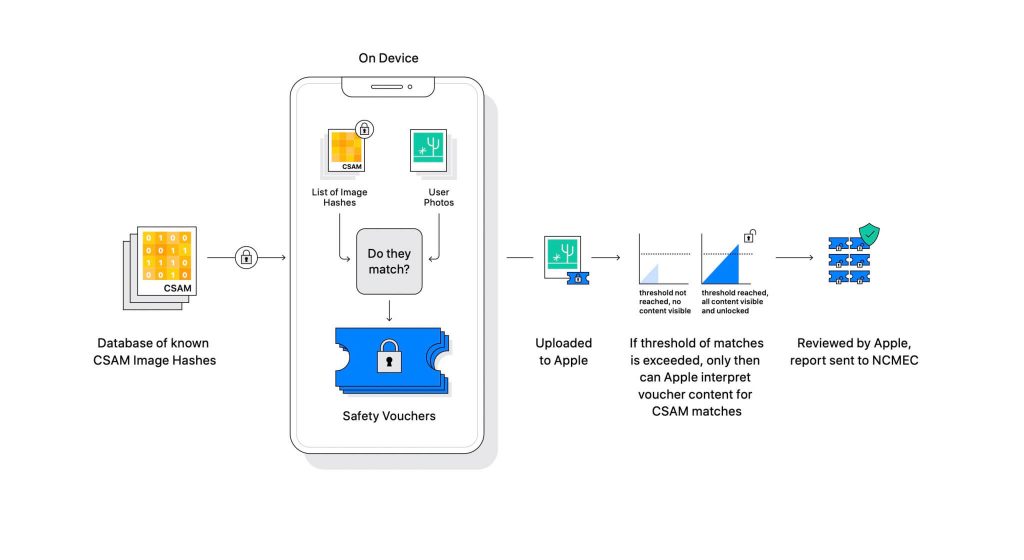

Apple heeft de technologie onthuld als onderdeel van een komende software-update. Het werkt door de foto's die gebruikers uploaden op iCloud te vergelijken met een bekende CSAM-database die wordt onderhouden door het National Center for Missing Exploited Children (NCMEC) en andere kinderveiligheidsorganisaties. Maar het scannen van de foto's zou een enorme inbreuk op de privacy zijn, dus in plaats daarvan matcht de technologie van Apple, genaamd NeuralHash, de hashes van de afbeeldingen met de hashes die door NCMEC worden geleverd.

De database met bekende CSAM-hashes wordt op elk apparaat opgeslagen. Het matchingsproces is volledig cryptografisch van aard. Apple zegt dat zijn cryptografietechnologie een veilige voucher creëert wanneer een match wordt gevonden en het resultaat opslaat. De afbeelding en de voucher worden geüpload naar iCloud als de gebruiker het delen van iCloud-foto's heeft ingeschakeld.

Apple creëerde een ander mechanisme waarmee de voucher beveiligd blijft tegen elke tussenkomst, ook die van Apple. Zie het als een slot dat pas wordt ontgrendeld als het een bepaald aantal bereikt.

(Afbeelding tegoed: Apple)

Apple kan de afbeelding die is opgeslagen in de cryptografische voucher niet zien. Maar zodra de drempel is overschreden, zal Apple handmatig ingrijpen. Dit onderdeel is belangrijk om ervoor te zorgen dat het systeem geen fout heeft geproduceerd. Iemand van Apple zal de afbeelding handmatig controleren en bevestigen of het echt CSAM is. Als blijkt dat de afbeelding CSAM is, wordt het account van de gebruiker verwijderd en worden wetshandhavingsinstanties op de hoogte gebracht van de persoon.

Apple stelt dat de geselecteerde drempel een kans van 1 op een biljoen oplevert voor het onjuist markeren van een account.

Het valt niet te ontkennen dat CSAM een enorm probleem is. Toen end-to-end encryptie werd gecreëerd om de privacy te versterken, bood het roofdieren ook bescherming tegen wetshandhaving. Ze kunnen dergelijk materiaal delen en de detectie van wetshandhavers ontwijken.

Een manier om dit te voorkomen, is door alle afbeeldingen te scannen die worden geüpload naar cloudservices, zoals Dropbox, OneDrive, Google Drive, iCloud. Apple leidde echter een op privacy gerichte aanpak waarbij de afbeeldingen niet worden gescand, maar in plaats daarvan hashes.

Een hash is een cryptografische waarde van een invoer die door een algoritme is gehaald. Het resultaat is een hash-waarde die uniek is voor de invoer, zoals een afbeelding. Dus in plaats van de afbeeldingen zelf te vergelijken, kunnen hun hash-waarden worden vergeleken om te bepalen of het dezelfde afbeeldingen zijn of niet.

Dat klinkt allemaal perfect, toch? Niet precies. Privacy-experts beweren dat niets Apple ervan weerhoudt om de database van CSAM te vervangen door een andere. De nieuwe database kan rechtenactivisten, vrijheidsverdedigers en alles wat het verhaal van een regering niet ondersteunt, identificeren. Kortom, het zou kunnen worden bewapend voor bewaking.

Sinds de aankondiging ligt Apple wereldwijd onder vuur van privacy-experts. De technologie wordt beschreven als een achterdeur die autoritaire regeringen uiteindelijk zullen gaan gebruiken.

Hoewel Apple toezegt dat het niet zal toegeven aan eisen van regeringen, baart het bestaan van dergelijke technologie de experts zorgen. Privacyorganisaties zoals Electronic Frontier Foundation (EFF) – inclusief ex-CIA-klokkenluider Edward Snowden – hebben zich uitgesproken over de verhuizing. En maar liefst 90+ maatschappelijke organisaties hebben een open brief aan Apple om af te zien van de vrijgave van zijn CSAM-detectietechnologie. De aankondiging heeft ook naar verluidt leidde tot kritiek binnen Apple.

Interessant is dat hetzelfde bedrijf ooit tegen de FBI en de federale rechtbank vocht tegen het creëren van een aangepast besturingssysteem in de San Bernadino-zaak van 2015. Apple noemde redenen voor mogelijk misbruik van de aangepaste iOS-versie die de beveiliging van de iPhone kan omzeilen, en noemde het zelfs 'software-equivalent van kanker'.

Apple was erg beducht voor het maken van iets dat mogelijk misbruikt kon worden. Jaren later lijkt Apple echter in tegenspraak met zijn eigen standpunt over privacy. Hoewel Apple blijft zeggen dat veel van de scepsis te wijten is aan verwarring over hoe het werkt, hebben privacy-experts elke uitleg die Apple heeft gegeven, verworpen, inclusief een dreigingsmodel document waarin wordt uiteengezet hoe het systeem is ontworpen om met interferentie en fouten om te gaan.

CSAM-detectiesysteem is deels apparaat en deels cloud. Het systeem werkt alleen volledig als u iCloud-foto's hebt ingeschakeld. Als u het uitschakelt, wordt de andere helft van het systeem uitgeschakeld, wat nodig is om de gedetecteerde resultaten Apple te laten bereiken.

Er is geen manier om scannen op het apparaat uit te schakelen. En Apple heeft het systeem zo gemaakt

dat het de gebruiker niet op de hoogte stelt als er een CSAM op het apparaat wordt gedetecteerd.

CSAM van Apple bestaat uit twee delen: iCloud en Berichten.

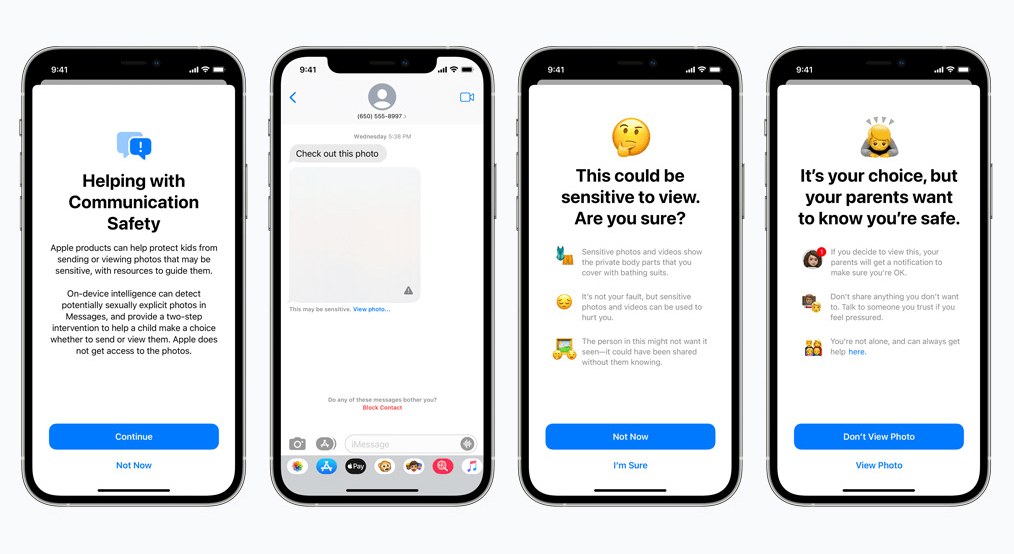

Communicatieveiligheid voor Berichten werkt anders dan zijn iCloud-tegenhanger. Het maakt gebruik van machine learning op het apparaat om vast te stellen of een inkomend of uitgaand bericht seksueel expliciete foto's bevat. Ouders kunnen de functie voor kinderen inschakelen op hun iCloud Family-account.

De foto wordt vervaagd als deze seksueel expliciet van aard is en als gevoelig is gemarkeerd. Als de gebruiker toch doorgaat met het bekijken van de foto, krijgt de ouder daar een melding over. Dit werkt ook wanneer een kind een foto probeert te verzenden die is gemarkeerd als seksueel expliciet.

In een recente ontwikkeling kondigde Apple zijn plannen aan om de uitrol van CSAM tot later uit te stellen.

Wij, als voorstanders van privacy, zijn er sterk van overtuigd dat als er tools bestaan, deze kunnen worden gemanipuleerd voor slechte doeleinden. Er zijn momenteel miljarden iPhones en iPads in de wereld; het implementeren van een technologie die onder dwang kan worden aangepast aan een doel door onderdrukkende regeringen is een reële mogelijkheid.

© Copyright 2024 Snelste VPN - Alle rechten voorbehouden.

Mis deze deal niet, hij wordt GRATIS geleverd met Password Manager.

Deze website maakt gebruik van cookies, zodat wij u de best mogelijke gebruikerservaring kunnen bieden. Cookies worden opgeslagen in uw browser en voeren functies uit zoals u herkennen wanneer u terugkeert naar onze website en helpen ons team om te begrijpen welke delen van de website u het meest interessant en nuttig vindt.

Strikt Noodzakelijke Cookie moet te allen tijde worden ingeschakeld, zodat we uw voorkeuren voor cookies kunnen opslaan.

Als u deze cookie uitschakelt, kunnen we uw voorkeuren niet opslaan. Dit betekent dat u cookies opnieuw moet inschakelen of uitschakelen.