Ömür Boyu %93 İNDİRİM

Özel Fırsat

Bu fırsatı kaçırmayın, Parola Yöneticisi ÜCRETSİZ olarak gelir.

Ön Onay %93 kapalı FastestVPN ve boşuna PassHulk Şifre Yöneticisi ÜCRETSİZ

Bu Fırsatı Hemen Alın!By Nick Anderson Yorum yok 6 dakikadır.

Apple yakın zamanda gelecekteki bir iOS güncellemesinin parçası olarak gelecek iki özelliği duyurdu. İki özellik, gizlilik savunucularından çok eleştiri aldı. Apple, yaklaşımının kullanıcıların gizliliğini ihlal etmediğine olan inancını koruyor.

Çocukların Cinsel İstismarı Materyali'nin (CSAM) ne olduğunu ve Apple'ın dünya çapındaki gizlilik uzmanlarının tepkisine neden olan bununla nasıl mücadele ettiğini tartışalım.

Çocukların Cinsel İstismarı Materyali (CSAM), reşit olmayan çocuklarla ilgili cinsel materyal içeren her şeydir. CSAM tespiti, bu tür içeriği bilinen bir CSAM veritabanıyla eşleştirerek bulan bir teknolojidir.

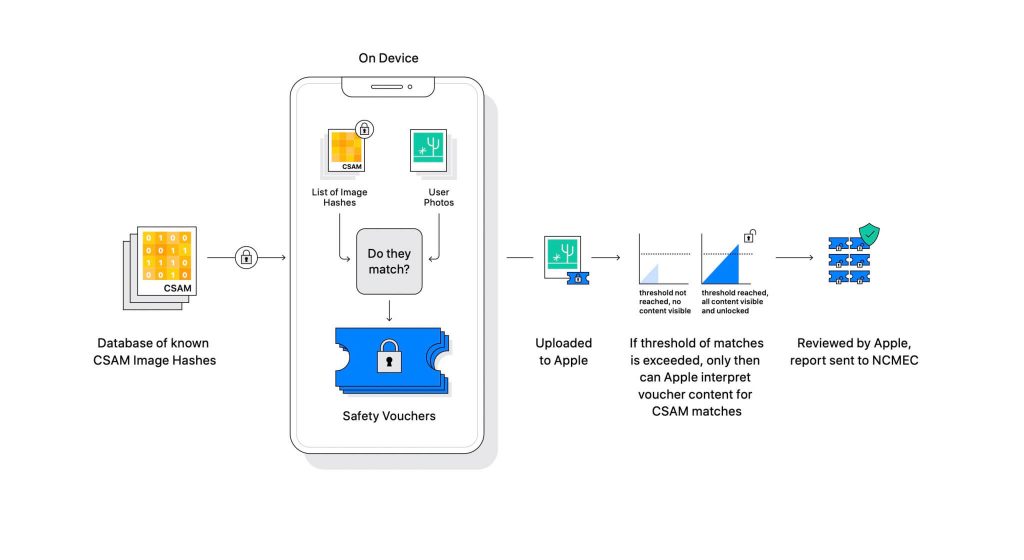

Apple, teknolojiyi yaklaşan bir yazılım güncellemesinin parçası olarak açıkladı. Kullanıcıların iCloud'a yüklediği fotoğrafları Ulusal Kayıp İstismara Uğrayan Çocuklar Merkezi (NCMEC) ve diğer çocuk güvenliği kuruluşları tarafından sağlanan bilinen bir CSAM veri tabanıyla karşılaştırarak çalışır. Ancak resimleri taramak büyük bir gizlilik ihlali olacaktır, bu nedenle bunun yerine Apple'ın NeuralHash adlı teknolojisi, görüntülerin karma değerlerini NCMEC tarafından sağlanan karmalarla karşılaştırır.

Bilinen CSAM karmalarının veritabanı her cihazda saklanacaktır. Eşleştirme işlemi doğası gereği tamamen kriptografiktir. Apple, kriptografi teknolojisinin bir eşleşme bulunduğunda güvenli bir kupon oluşturduğunu ve sonucu sakladığını söylüyor. Kullanıcı iCloud Fotoğrafları paylaşımını etkinleştirmişse, resim ve kupon iCloud'a yüklenir.

Apple, kuponun Apple'ınki de dahil olmak üzere herhangi bir müdahaleye karşı güvende kalmasını sağlayan başka bir mekanizma oluşturdu. Bunu, yalnızca belirli bir sayıya çarptığında açılan bir kilit olarak düşünün.

(Resim kredisi: Elma)

Apple, kriptografik makbuzda depolanan görüntüyü göremez. Ancak eşik aşıldığında, Apple manuel müdahale yapacak. Bu kısım, sistemin bir hata üretmediğinden emin olmak için önemlidir. Apple'dan biri görüntüyü manuel olarak kontrol edecek ve gerçekten CSAM olup olmadığını onaylayacaktır. Görüntünün CSAM olduğu tespit edilirse kullanıcının hesabı silinecek ve kişi hakkında kolluk kuvvetlerine bilgi verilecektir.

Apple, seçilen eşiğin bir hesabı yanlış bir şekilde işaretlemek için trilyonda 1 olasılık sağladığını belirtiyor.

CSAM'ın çok büyük bir sorun olduğu inkar edilemez. Mahremiyeti desteklemek için uçtan uca şifreleme oluşturulduğunda, aynı zamanda yırtıcılara kanun yaptırımlarından korunma sağladı. Bu tür materyalleri paylaşabilir ve kolluk kuvvetlerinin tespitinden kurtulabilirler.

Bunu önlemenin bir yolu, Dropbox, OneDrive, Google Drive, iCloud gibi bulut hizmetlerine yüklenen tüm görüntüleri taramaktır. Bununla birlikte, Apple, görüntülerin taranmasını değil, bunun yerine karmaları içeren gizlilik odaklı bir yaklaşıma öncülük etti.

Karma, bir algoritmadan geçirilen bir girdinin kriptografik değeridir. Sonuç, görüntü gibi girdiye özgü bir hash değeri olacaktır. Dolayısıyla, görüntülerin kendilerini karşılaştırmak yerine, aynı görüntüler olup olmadıklarını belirlemek için hash değerleri karşılaştırılabilir.

Bunların hepsi kulağa mükemmel geliyor, değil mi? Tam olarak değil. Gizlilik uzmanları, Apple'ın CSAM veritabanını bir başkasıyla değiştirmesini hiçbir şeyin engelleyemeyeceğini savunuyor. Yeni veritabanı, hak aktivistlerini, özgürlük destekçilerini ve bir hükümetin anlatımını desteklemeyen her şeyi tanımlayabilir. Kısacası, gözetleme için silah haline getirilebilir.

Duyurusundan bu yana, Apple dünya çapındaki gizlilik uzmanlarının ateşi altında. Teknoloji, otoriter hükümetlerin eninde sonunda kullanmaya başlayacakları bir arka kapı olarak tanımlanıyor.

Apple, hükümetlerden gelen hiçbir talebi kabul etmeyeceğini taahhüt ederken, böyle bir teknolojinin varlığı bile uzmanları endişelendiriyor. gibi gizlilik kuruluşları Electronic Frontier Foundation (EFF) - eski CIA muhbiri Edward Snowden dahil - hareket hakkında seslerini yükselttiler. Ve 90'dan fazla sivil toplum kuruluşu bir bildiri yayımladı. açık mektup CSAM algılama teknolojisinin piyasaya sürülmesinden vazgeçmesi için Apple'a. Duyuru ayrıca söylendiğine göre Apple içinde eleştirilere yol açtı.

İlginç bir şekilde, aynı şirket bir zamanlar 2015 San Bernadino davasında FBI ve federal mahkemeyle özel bir işletim sistemi oluşturmaya karşı mücadele etti. Apple, özel iOS sürümünün iPhone'un güvenliğini atlayabilecek potansiyel kötüye kullanımının nedenlerini gösterdi, hatta onu "kanserin yazılım eşdeğeri" olarak adlandırdı.

Apple, kötüye kullanım potansiyeline sahip bir şey yaratma konusunda çok endişeliydi. Ancak, yıllar sonra Apple, gizlilik konusundaki kendi duruşuyla çelişiyor gibi görünüyor. Apple, şüpheciliğin çoğunun nasıl çalıştığıyla ilgili kafa karışıklığından kaynaklandığını söylemeye devam ederken, gizlilik uzmanları, Apple'ın yayınladığı herhangi bir açıklamayı reddetti. tehdit modeli belgesi sistemin girişim ve hataları işlemek için nasıl tasarlandığını gösterir.

CSAM algılama sistemi, kısmen cihaz ve kısmen buluttur. Sistem, yalnızca iCloud Fotoğrafları açıkken tam olarak çalışır. Kapatılması, tespit edilen sonuçların Apple'a ulaşması için gerekli olan sistemin diğer yarısını devre dışı bırakacaktır.

Cihaz içi taramayı kapatmanın bir yolu yoktur. Ve Apple sistemi böyle yaptı

cihazda bir CSAM algılanırsa kullanıcıya bildirimde bulunmadığını.

Apple'ın CSAM'sinin iki bölümü vardır: iCloud ve Mesajlar.

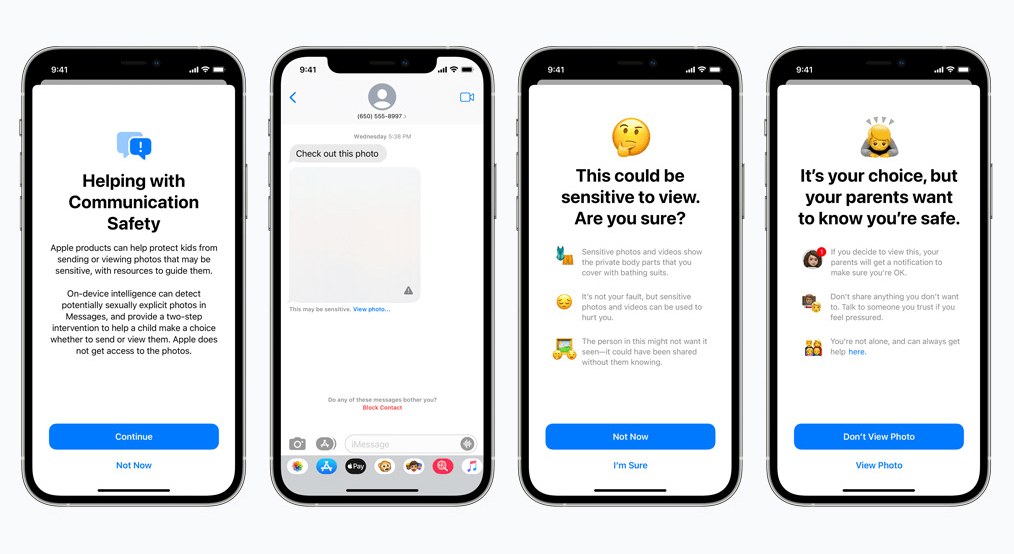

Mesajlar için iletişim güvenliği, iCloud muadilinden farklı çalışır. Gelen veya giden bir mesajın müstehcen fotoğraflar içerip içermediğini belirlemek için cihazdaki makine öğrenimini kullanır. Ebeveynler, iCloud Family hesaplarında çocukları için bu özelliği etkinleştirebilecek.

Fotoğraf, doğası gereği müstehcen ise ve hassas olarak işaretlenmişse bulanık olacaktır. Kullanıcı yine de fotoğrafı görüntülemeye devam ederse ebeveyn bununla ilgili bir bildirim alır. Bu, bir çocuk müstehcen olarak işaretlenmiş bir fotoğrafı göndermeye çalıştığında da işe yarar.

Yakın tarihli bir gelişmede Apple, CSAM'ın kullanıma sunulmasını daha sonraya erteleme planlarını duyurdu.

Gizlilik savunucuları olarak bizler, eğer araçlar varsa kötü amaçlar için manipüle edilebileceklerine kuvvetle inanıyoruz. Şu anda dünyada milyarlarca iPhone ve iPad var; baskıcı hükümetler tarafından bir amaca uyacak şekilde zorla değiştirilebilecek bir teknolojinin uygulanması gerçek bir olasılıktır.

© Copyright 2024 En hızlı VPN - Tüm Hakları Saklıdır.

Bu fırsatı kaçırmayın, Parola Yöneticisi ÜCRETSİZ olarak gelir.

Bu web sitesi, size mümkün olan en iyi kullanıcı deneyimini sunabilmemiz için çerezler kullanmaktadır. Çerez bilgileri tarayıcınızda saklanır ve web sitemize geri döndüğünüzde sizi tanımak ve ekibimizin en ilginç ve yararlı bulduğunuz web sitesinin hangi bölümlerini anladığına yardımcı olmak gibi işlevleri yerine getirir.

Çerez ayarları için tercihlerinizi kaydedebilmemiz için, mutlaka Gerekli Çerez her zaman etkinleştirilmelidir.

Bu çerezi devre dışı bırakırsanız, tercihlerinizi kaydedemeyiz. Bu, bu web sitesini her ziyaret ettiğinizde, çerezleri tekrar etkinleştirmeniz veya devre dışı bırakmanız gerekeceği anlamına gelir.