Kritt 93% OFF op Liewensdauer

Exklusiv Deal

Verpasst net dësen Deal, et kënnt mat Passwuert Manager GRATIS.

kréien 93% ausgeschalt FastestVPN a profitéieren PassHulk Password Manager GRATIS

Kritt dësen Deal elo!By Nick Anderson Nee Comments 6 Minutt

Apple huet viru kuerzem zwou Features ugekënnegt déi als Deel vun engem zukünftegen iOS Update kommen. Déi zwee Fonctiounen si mat vill Kritik vun Privatsphär Affekote begéint. Apple bleift fest a senger Iwwerzeegung datt seng Approche d'Privatsphär vun de Benotzer net verletzt.

Loosst eis diskutéieren wat Material fir sexuellem Mëssbrauch vu Kanner (CSAM) ass a wéi Apple et unhëlt, a verursaacht Réckschlag vu Privatsphärsexperten weltwäit.

Child Sexual Abuse Material (CSAM) ass alles wat sexuell Material am Zesummenhang mat mannerjärege Kanner enthält. CSAM Detektioun ass eng Technologie déi esou Inhalter fënnt andeems se et mat enger bekannter CSAM Datebank passen.

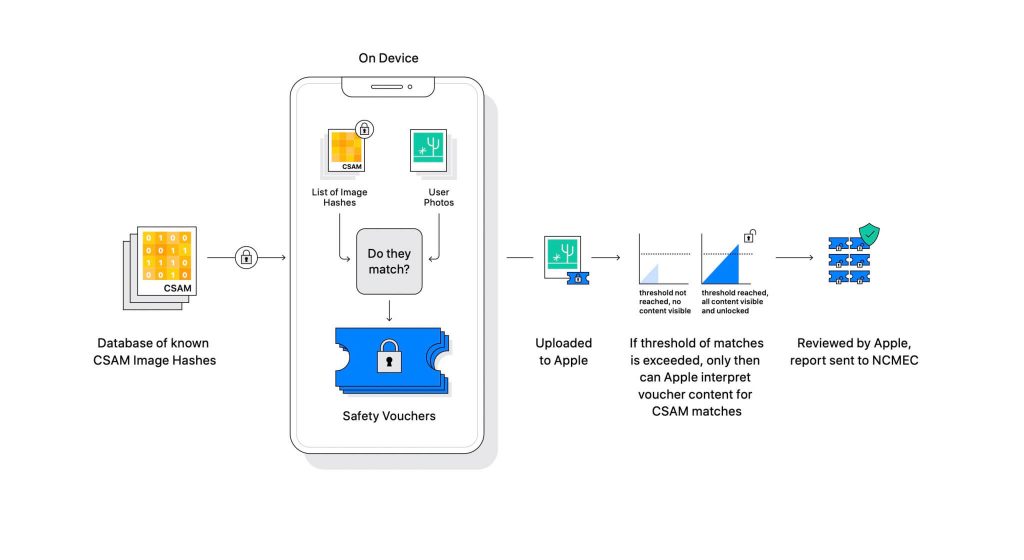

Apple huet d'Technologie als Deel vun engem Upëff vum Softwareupdate opgedeckt. Et funktionnéiert andeems d'Fotoen déi Benotzer op iCloud eropluede mat enger bekannter CSAM-Datebank vergläicht, déi vum National Center for Missing Exploited Children (NCMEC) an aner Kannersécherheetsorganisatiounen erhale ginn. Awer d'Biller ze scannen wier e grousse Verstouss géint d'Privatsphär, also amplaz, Apple d'Technologie genannt NeuralHash entsprécht Hashes vun de Biller géint d'Hashes, déi vun NCMEC geliwwert ginn.

D'Datebank vu bekannte CSAM Hashes gëtt op all Apparat gespäichert. De passende Prozess ass komplett kryptographesch an der Natur. Apple seet datt seng Kryptografietechnologie e séchere Bong erstellt wann e Match fonnt gëtt an d'Resultat späichert. D'Bild an de Bong ginn op iCloud eropgelueden wann de Benotzer iCloud Fotoen Deele aktivéiert huet.

Apple huet en anere Mechanismus erstallt deen de Bong erlaabt fir sécher ze bleiwen géint all Interventioun, och Apple's. Denkt un et als e Spär deen nëmmen opmaacht wann et eng gewëssen Zuel trefft.

(Bildkreditt: Apple)

Apple kann d'Bild net gesinn, dat am kryptografesche Bong gespäichert ass. Awer wann d'Schwell iwwerschratt ass, wäert Apple eng manuell Interventioun huelen. Dësen Deel ass wichteg fir sécherzestellen datt de System kee Feeler produzéiert huet. Een vun Apple wäert d'Bild manuell iwwerpréiwen a bestätegen ob et wierklech CSAM ass. Wann d'Bild als CSAM fonnt gëtt, gëtt de Benotzerkont geläscht, an d'Haftpflichtbehörden ginn iwwer d'Persoun informéiert.

Apple seet datt de gewielte Schwell eng 1 an enger Billioun Wahrscheinlechkeet liwwert fir e Kont falsch ze markéieren.

Et gëtt kee verleegnen datt CSAM e grousse Problem ass. Wann d'Enn-zu-Enn Verschlësselung erstallt gouf fir d'Privatsphär ze stäerken, huet et och Feindesécherheet vun der Affekot geliwwert. Si kënnen esou Material deelen an d'Erkennung vu Gesetzesvollzéier evitéieren.

Ee Wee fir et ze vermeiden ass all Biller ze scannen déi op Cloud Servicer eropgeluede ginn, wéi Dropbox, OneDrive, Google Drive, iCloud. Wéi och ëmmer, Apple huet eng Privatsphär fokusséiert Approche gefouert déi net Scannen vun de Biller involvéiert, awer amplaz Hashes.

En Hash ass e kryptographesche Wäert vun engem Input deen duerch en Algorithmus passéiert ass. D'Resultat wäert en Hashwäert sinn deen eenzegaarteg ass fir den Input, sou wéi e Bild. Also amplaz d'Biller selwer ze vergläichen, kënnen hir Hashwäerter verglach ginn fir ze bestëmmen ob se déiselwecht Biller sinn oder net.

All dat kléngt perfekt, richteg? Net genau. Dateschutzexperten argumentéieren datt näischt Apple hält fir d'Datebank vun CSAM mat engem aneren z'ersetzen. Déi nei Datebank konnt Rechteraktivisten identifizéieren, Fräiheetssupporter, an alles wat d'Narrativ vun enger Regierung net ënnerstëtzt. Kuerz gesot, et kéint fir d'Iwwerwaachung bewaffnet ginn.

Zënter senger Ukënnegung ass Apple ënner Feier vu Privatsphärsexperten weltwäit. D'Technologie gëtt als Hannerdier beschriwwen, déi autoritär Regierunge schliisslech benotze wäerten.

Wärend Apple engagéiert datt et keng Fuerderunge vu Regierungen zouginn, huet d'Existenz vun esou Technologie d'Experten besuergt. Privatsphär Organisatiounen wéi Electronic Frontier Foundation (EFF) - dorënner den Ex-CIA Whistleblower Edward Snowden - ware vokal iwwer d'Beweegung. An esou vill wéi 90+ Zivilgesellschaft Organisatiounen hunn eng Verëffentlechung Bréif un Apple fir d'Verëffentlechung vu senger CSAM Detektiounstechnologie opzeginn. D'Ukënnegung huet och confirméiert huet Kritik bannent Apple ausgeléist.

Interessanterweis huet déiselwecht Firma eemol den FBI an de Bundesgeriicht gekämpft géint e personaliséierten OS am 2015 San Bernadino Fall ze kreéieren. Apple zitéiert Grënn fir potenziell Mëssbrauch vun der personaliséierter iOS Versioun, déi d'Sécherheet vum iPhone ëmgoe kann, och nennt et "Software-Äquivalent vu Kriibs."

Apple war ganz Angscht eppes ze kreéieren dat de Potenzial fir Mëssbrauch hat. Wéi och ëmmer, Joer erof, Apple widdersprécht anscheinend seng eege Haltung iwwer Privatsphär. Wärend Apple weider seet datt vill vun der Skepsis wéinst Duercherneen ass wéi et funktionnéiert, hunn Privatsphärsexperten all Erklärung entlooss, déi Apple erausginn huet, inklusiv engem Gefor Modell Dokument dat leet wéi de System entwéckelt ass fir Stéierungen a Feeler ze handhaben.

CSAM Detektiounssystem ass Deel Apparat an Deel Wollek. De System funktionnéiert nëmme voll wann Dir iCloud Fotoen ageschalt hutt. Ausschalten wäert déi aner Halschent vum System auszeschalten, wat néideg ass fir déi erkannt Resultater fir Apple z'erreechen.

Et gëtt kee Wee fir den On-Device Scannen auszeschalten. An Apple huet de System esou gemaach

datt et de Benotzer net informéiert wann e CSAM um Apparat festgestallt gëtt.

Et ginn zwee Deeler vum Apple CSAM: iCloud a Messagen.

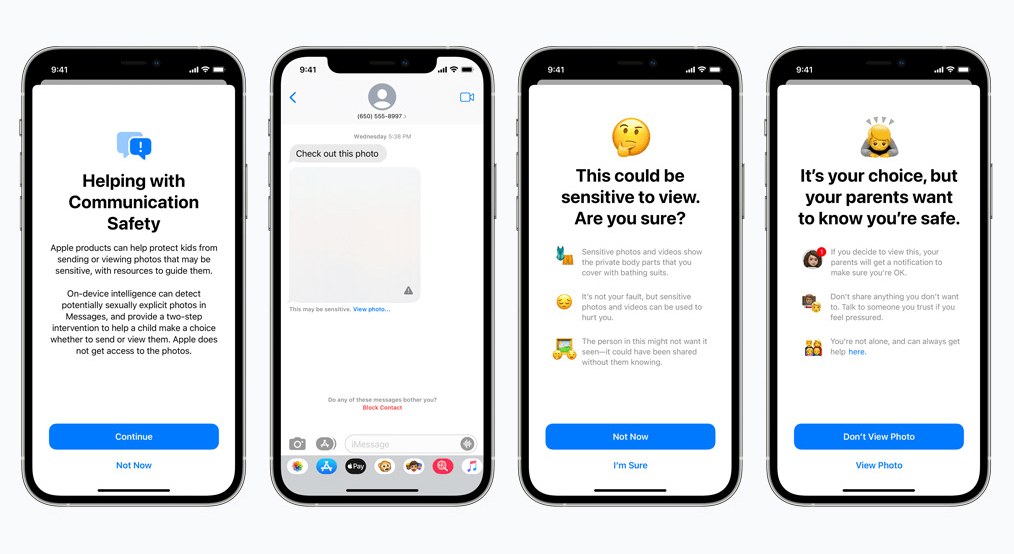

Kommunikatioun Sécherheet fir Messagen Wierker anescht wéi seng iCloud Géigespiller. Et benotzt on-Device Maschinn Léieren fir z'identifizéieren ob eng erakommen oder erausginn Message sexuell explizit Fotoen enthält. D'Eltere kënnen d'Feature fir Kanner op hirem iCloud Family Kont aktivéieren.

D'Foto gëtt verschwonn wann se sexuell explizit an der Natur ass an als sensibel markéiert ass. Wann de Benotzer souwisou weider geet fir d'Foto ze gesinn, kritt den Elterendeel eng Notifikatioun doriwwer. Dëst funktionnéiert och wann e Kand probéiert eng Foto ze schécken déi sexuell explizit markéiert ass.

An enger rezenter Entwécklung huet Apple seng Pläng ugekënnegt fir d'Rollout vu CSAM bis spéider ze verzögeren.

Mir, als Privatsphär Verdeedeger, gleewen staark datt wann Tools existéieren, se fir krank Zwecker manipuléiert kënne ginn. Et gi Milliarden vun iPhones an iPads an der Welt grad elo; eng Technologie ëmzesetzen déi zwanghaft geännert ka ginn fir en Zweck vun oppressive Regierungen ze passen ass eng reell Méiglechkeet.

© Copyright 2024 Schnellst VPN - All Rechter reservéiert.

Verpasst net dësen Deal, et kënnt mat Passwuert Manager GRATIS.

Dës Websäit benotzt Cookien, fir datt mir Iech mat der beschtméiglecher Usererfahrung méiglech maachen. Cookie-Informatioun gëtt an Ärem Browser gespäichert a funktionéiert Funktiounen, wéi Dir unerkannt hutt, wann Dir op eis Websäit zréckkoum an eis Team hëllefe fir ze verstoen, wéi vun de Websäit déi Dir am meeschten interessant a nëtzlech fannt.

Korrespondent Notiz Cookie däerf ëmmer nees aktivéiert ginn fir datt Dir Är Astellungen fir Cookie-Astellungen speichert.

Wann Dir dës Cookie deaktivéiere kënnt, kënnt Dir Är Preferenzen net späicheren. Dëst bedeit datt all Kéier wann Dir dës Websäit besicht, musst Dir Cookien erëm erliewen an deaktivéieren.